생성형 AI의 기반 Transformer 개념 정리

2022년 11월부터 급속도로 발전하게 된 생성형 AI, 그 중에서 챗GPT가 보여주는 능력은 타의 추종을 불허하는데요. 그런 챗GPT도 사실 구글이 오픈소스로 공개한 Transformer 모델을 기반으로 만들어졌다는 사실을 알고계신가요?

Transformer 모델을 설명하기 위해 초기 AI 모델 RNN과 LSTM에 대해 간략하게 설명하고 이어서 진행하겠습니다.

1990년대 초 AI 모델

Transformer가 등장하기 전 1990년대에는 순환신경망(RNN)과 장단기 메모리(LSTM)가 언어 처리 모델에 주로 사용되었습니다. 순환신경망(RNN)은 시계열 데이터처럼 연속되는 정보를 처리하는 AI 모델입니다.

RNN은 문장을 처리할 때 한 단어씩 순차적으로 읽으면서 단어의 정보를 기억하고 문장 전체의 의미를 파악합니다. 하지만 RNN은 문장이 길어질수록 단어 사이의 관계를 잘 파악하지 못하는 단점이 있습니다.

그래서 단점을 보완해 등장한 모델이 장단기 메모리(LSTM)입니다. RNN의 한 종류로, 긴 문장에서 중요한 정보를 잘 기억하고, 불필요한 정보는 잊어버릴 수 있습니다. 하지만 RNN의 단점을 보완했음에도 RNN과 동일하게 긴 문장에서 의미를 파악하지 못하고, 데이터 학습 훈련에 적합하지 않았습니다.

2017년 Transformer 모델의 등장

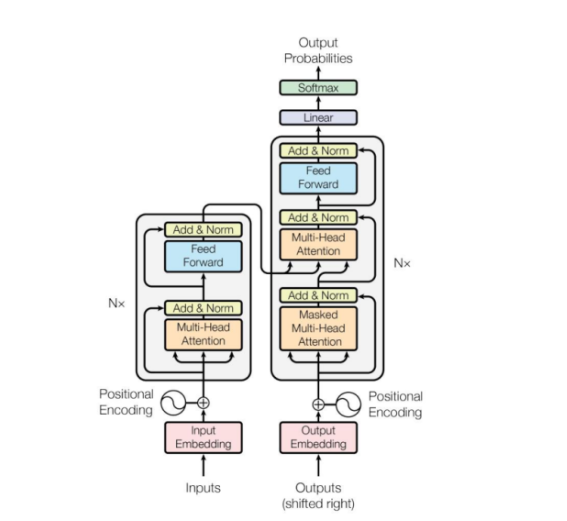

2017년 구글 연구팀이 발표한 논문 'Attention is All You Need'에서 Transformer 모델이 처음 소개되었습니다. Transformer 모델은 기존 RNN과 LSTM이 순차적으로 정보를 차례로 처리하던 방식과 다른 방식을 활용했습니다.

Transformer는 모든 단어를 동시에 볼 수 있으며, 문장 속에서 각 단어가 서로 어떻게 연관되어 있는지를 한 번에 파악합니다. 이 방식으로 복잡한 언어 패턴을 더 빠르고 정확하게 처리할 수 있습니다.

예를 들어 "The bank can be busy on Mondays"라는 문장에서 'bank'라는 단어는 '금융 기관'을 의미할 수도 있고, '강둑'을 의미할 수도 있습니다. Transformer는 문장 전체를 한 번에 보면서 'bank'와 'busy', 'Mondays'와 같은 단어들 사이의 관계를 분석합니다. 이 분석을 통해 'bank'가 여기서 '금융 기관'을 의미한다는 것을 파악합니다.

논문을 살펴보면, Transformer는 대량의 데이터를 병렬로 처리할 수 있어, 언어와 문맥을 더 잘 이해하고 생성할 수 있다고 합니다.(self-attention) 이 같은 처리 방식을 통해 복잡한 언어 패턴을 학습할 수 있어 GPT 시리즈 모델의 기반이 된 것 입니다. 오늘도 글을 읽어주셔서 감사합니다.

부루퉁의AI 블로그: https://blog.naver.com/ldlquddnr