DeepSeek는 어떻게 적은 비용으로ChatGPT의 성능을 낼까?

안녕하세요, 부루퉁입니다.

겨우 80억 원 정도의 비용으로 OpenAI의 ChatGPT o1과 맞먹는 성능을 내는 중국의 LLM(거대 언어 모델) DeepSeek. OpenAI, Meta, Anthropic 등 미국의 AI 기업들은 조 단위의 막대한 비용을 투자하며 LLM을 개발해 왔었는데요. 과연 DeepSeek는 어떻게 이렇게 적은 비용으로 똑똑하고 강력한 AI를 만들 수 있었을까요? 오늘은 DeepSeek에 대해 쉽게 풀어보겠습니다.

DeepSeek이란?

DeepSeek은 중국의 헤지펀드 회사 '환퐝퀀트' 소속 인공지능 연구 기업이자, 해당 연구소에서 개발한 오픈 웨이트(Open-Weights) LLM 모델의 이름입니다. 원래 금융 데이터를 분석해 투자 전략을 개발하는 기업이었는데, AI의 중요성을 깨닫고 자체적으로 언어 모델을 연구하기 시작했습니다.

2024년 12월, DeepSeek은 DeepSeek-V3라는 모델을 공개했는데, 미국의 대표적인 LLM들과 경쟁할 만한 성능을 보여주면서, 개발 비용이 단 80억 원 수준이었다는 점에서 전세계를 놀라게 했습니다.

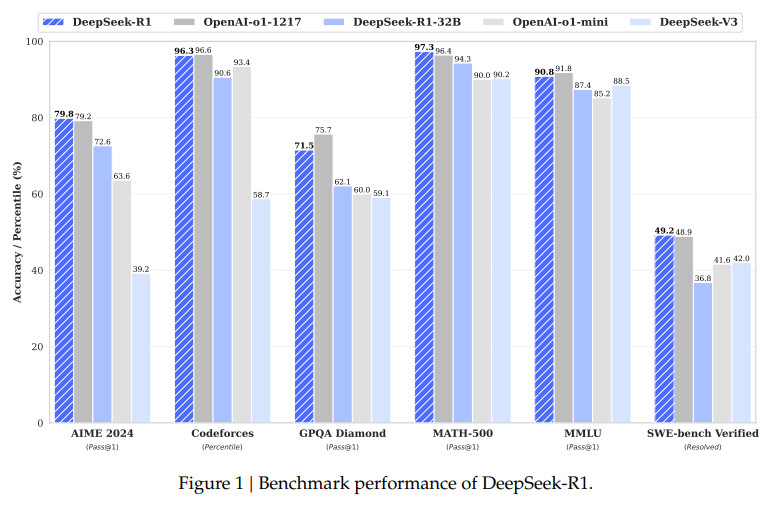

이후 2025년 1월에는 더욱 발전된 DeepSeek-R1을 발표했는데, 이 모델은 OpenAI의 ChatGPT o1과 비슷한 성능을 내면서도 비용을 최대 95%까지 절감할 수 있도록 설계되었습니다.

적은 비용으로 강력한 AI를 만든 비결

1) 기존 모델과 다른 학습 방식

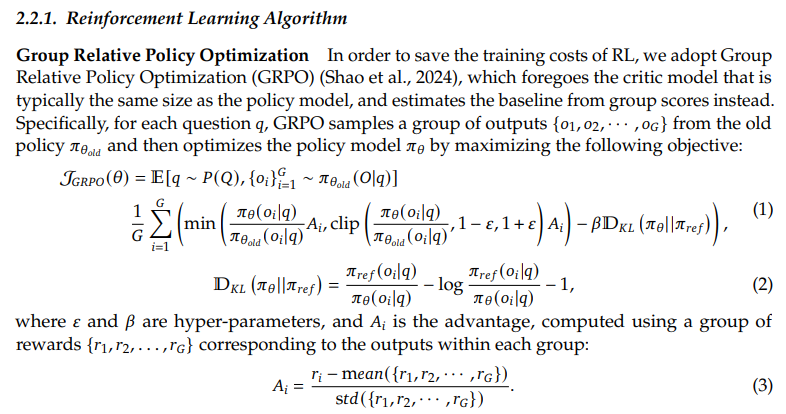

일반적인 AI 모델은 먼저 방대한 양의 데이터로 기본 훈련을 진행한 뒤, 사람이 직접 데이터를 선별해 AI를 정교하게 다듬는 '감독 학습(Supervised Fine-Tuning, SFT)'을 수행합니다. 이후 더 나은 답변을 제공할 수 있도록 '강화 학습(Reward-based Reinforcement Learning, RL)' 과정을 거치죠.

하지만 DeepSeek-R1은 감독 학습 과정을 완전 생략하고, 오직 강화 학습만으로 성능을 끌어올리는 방식을 사용했습니다. 즉, 사람이 직접 데이터를 가르치는 과정 없이 AI가 스스로 학습하면서 최적의 답을 찾아가는 것이죠. 이 방식으로 학습 비용을 획기적으로 절감하는 동시에 성능을 크게 개선하는 효과를 가져왔습니다.

일반적으로 LLM은 SFT(지도 학습) → RL(강화 학습) → 평가의 단계를 거치지만, DeepSeek R1-zero는 SFT 없이 RL로만 학습된 모델임.

이 방식이 학습 비용 절감과 모델의 유연성을 높이는 데 중요한 역할을 했음.

2) 테스트-타임 컴퓨트 기법

DeepSeek은 AI 모델이 실행되는 과정에서 추가적인 연산을 활용하는 테스트-타임 컴퓨트(Test-Time Compute, TTC) 기법을 적극 활용했습니다.

간단히 설명하면, 일반적인 AI 모델은 훈련 과정에서 학습한 내용을 그대로 실행하는 반면, DeepSeek은 AI가 실시간으로 연산을 수행하며 추가적으로 최적의 답을 찾는 방식을 도입했습니다. 장점은 다음과 같습니다.

✅ 적은 데이터로도 더 높은 성능을 발휘

✅ 학습 과정에서 필요했던 연산량을 실시간 처리로 분산

✅ 훈련 비용을 절감하면서도 더 정교한 AI 생성 가능

이 접근 방식은 OpenAI의 일리야 수츠케버가 주장했던 ASI(초인공지능)로의 직행 가능성을 뒷받침하는 핵심 기술이기도 합니다.

3) 비용 절감을 위한 최적화된 인프라 활용

OpenAI나 Google 같은 기업들은 AI 모델을 훈련할 때, 대규모 데이터센터에서 수천 개의 고성능 GPU를 사용하여 연산을 수행합니다. 그래서 전력 비용과 하드웨어 비용이 어마어마합니다. (DeepSeek은 H800 GPU로 학습(H100보다 낮은 성능의 GPU))

반면 DeepSeek은 상대적으로 적은 연산 자원만으로도 효율적인 학습을 할 수 있도록 모델을 최적화했는데요.

✅ 기존보다 가벼운 모델 구조 사용

✅ 연산이 덜 필요한 경량화된 알고리즘 채택

✅ 데이터 재사용 및 선택적 학습을 통해 학습 비용 절감

위와 같은 최적화로 OpenAI의 ChatGPT o1과 비슷한 성능을 내면서도 비용은 80억 원 수준으로 줄일 수 있었습니다.

AI 시장에 미친 충격

DeepSeek-R1은 OpenAI의 o1-mini를 뛰어넘고, o1과 맞먹는 수준을 보여줍니다. 그래서 최근 위기감을 느낀 OpenAI가 ChatGPT 무료 사용자들에게도 o3-mini를 서비스하기 시작했죠.

여기서 더 놀라운점은 DeepSeek-R1이 무료로 제공되며, OpenAI와 달리 완전한 오픈 소스 정책을 유지하고 있다는 것입니다. OpenAI는 상업적 이유로 모델을 비공개(클로즈드/CloseAI)로 운영하지만 DeepSeek은 AGI를 오픈 소스로 제공하는 것이 목표라고 밝혔습니다.

기존의 AI는 막대한 자본과 방대한 데이터, 고성능 연산 GPU가 있어야만 뛰어난 AI 모델을 개발할 수 있다고 여겨졌습니다. 하지만 DeepSeek의 사례는 그 공식이 더 이상 절대적이지 않음을 보여주고 있습니다. 특히, 단순한 비용 절감이 아니라 학습 방식의 변화를 통해 효율적인 성능 향상을 이뤘다는 점이 더욱 놀랍습니다. 마치 'CoT(Chain of Thought) 생각의 연결고리' 논문이 처음 공개되었을 때처럼, AI 기술의 새로운 가능성이 열린 순간입니다.

DeepSeek는 AI 개발의 경제적 장벽을 허물고, 더 강력하면서도 저렴하고 대중적인 AI 모델이 등장할 수 있음을 증명했습니다. 앞으로 AI는 점점 더 보편화되고, 누구나 쉽게 활용할 수 있는 기술로 자리 잡을 것입니다.

AI가 이토록 빠른 속도로 발전하는 것에 대해 여러분은 어떻게 생각하시나요? 이제 AI 개발 경쟁은 단순한 성능 싸움을 넘어 비용과 접근성까지 고려해야 하는 시대가 되었습니다. 여러 규제 속에서도 이 정도의 모델을 만들어낸 중국의 저력 또한 AI 시장의 판도를 더욱 흥미롭게 만들고 있습니다.

트렌드 도구

- Natura > 기억하고, 적용하고, 진화하는 AI(기억력, 성격, 주도성을 갖춘 가상 비서인 AI People을 소개합니다.)

- HuggingFace Spaces > 약 40만 개의 AI 도구를 검색하여 사용자에게 가장 적합한 사용을 제공하는 AI 앱 스토어입니다.

- 타나 > 음성과 AI를 이용해 메모를 처리하세요.

- Replit 모바일 앱 > 휴대폰에서 바로 텍스트 프롬프트가 포함된 앱과 AI 에이전트를 만들어보세요.

- Teamsaver.ai > 이메일을 통해 매일 팀 업데이트를 수집하는 AI 에이전트.

- Skyvern 2.0 > 일반 영어로 AI 브라우저 에이전트를 구축합니다.

- AI Dialog 1.0 재생 > 매우 감성적인 AI 텍스트 음성 변환 모델입니다.

부루퉁 인스타그램: https://www.instagram.com/boorutung/

부루퉁의AI 네이버 블로그: https://blog.naver.com/ldlquddnr

부루퉁의 업데이트되는 챗GPT 전자책: https://vo.la/blbLY

뉴스레터 광고 공간 (광고주를 모집합니다)

For newsletter banner advertising inquiries, please contact: Bopyo@aikoreacommunity.com

이곳에 서비스를 소개하세요!

뉴스레터 배너 광고 문의: Bopyo@aikoreacommunity.com

뉴스레터 편집장 소개

- 보표 홈페이지

- https://amzbopyo.com/

- 보표 SNS

- 보표 레터: https://www.bopyoletters.com/

- X(트위터): https://twitter.com/AIBopyo

- 스레드: https://www.threads.net/@bopyo.amz

- 링크드인: https://www.linkedin.com/in/bopyo-park-848631231/

- 인스타그램: https://www.instagram.com/bopyo.amz/

- AI 코리아 커뮤니티 아카데미

- https://app.aikoreacommunity.com/collections/932400