AI, 이미 당신의 동료!

하나만 알아도

o1이 등장한 이래 지속적으로 LLM의 추론 능력 향상이 주목받고 있어요. 그중 강화학습 기반의 RLVR(Reinforcement Learning with Verifiable Reward) 기법이 핵심적인 역할을 수행하고 있는데, 일반적으로 AI를 똑똑하게 만들려면 방대한 데이터가 필요하다고 생각하기 쉬워요.

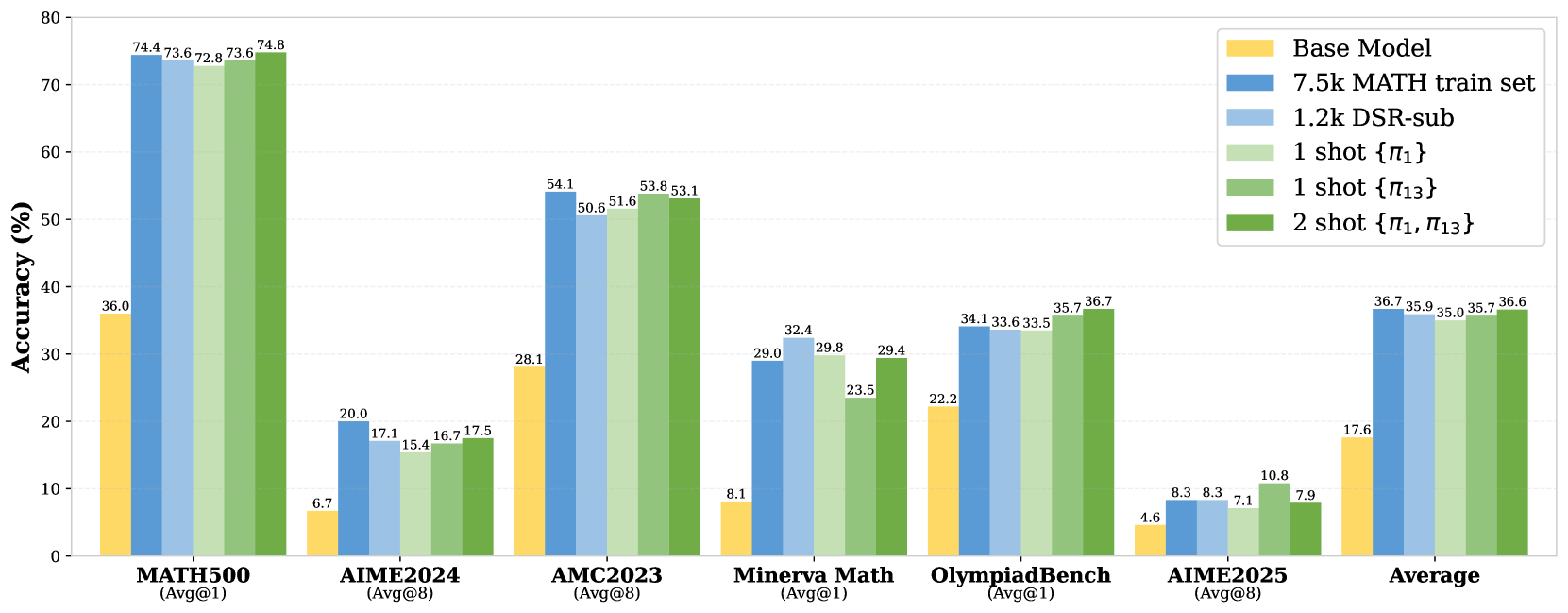

그런데 이번 분석 결과는 조금 달라요. 단 하나의 훈련 예시만으로도 LLM의 수학적 추론 능력을 비약적으로 향상시킬 수 있다는 사실이 밝혀졌어요. 이를 '1-shot RLVR(이하 원샷)'이라고 부를게요.

구체적으로, 특정 수학 문제 예시 단 1개를 사용해 'Qwen2.5-Math-1.5B'라는 모델을 훈련했더니, 대표적인 수학 벤치마크(MATH500) 점수가 36.0%에서 73.6%로 급등했어요. 여러 수학 벤치마크 평균 성능 역시 17.6%에서 35.7%로 크게 향상되었고요. 놀랍게도 1,200개 이상의 데이터를 사용해 훈련한 결과와 거의 비슷하거나, 단 2개의 예시만 사용했을 때는 오히려 더 좋은 성능을 보이기도 했어요.

또한, 특정 수학 영역(예: 기하) 문제 하나로 훈련해도 다른 영역(예: 대수, 정수론 등)의 문제 해결 능력이 함께 좋아지는 '교차 영역 일반화' 효과도 확인했어요. 훈련이 진행될수록 모델이 스스로 답을 검토하는('다시 생각하기', '재확인' 등) 경향이 늘어나는 점도 주목할 만해요.

결론적으로, LLM은 이미 내부에 상당한 추론 잠재력을 가지고 있고, '원샷' 같이 아주 적은 양의 적절한 데이터 자극만으로도 그 능력을 효과적으로 끌어낼 수 있어요. 앞으로는 누구나 AI한테 1000자 정도의 간단한 지식만 알려줘도 해당 분야의 전문가로 재탄생 시킬 수 있을지 몰라요.

진짜보다 진짜같은

MS는 공식 블로그를 통해 '서피스' 신제품 영상 광고 제작 과정을 상세히 공개했어요. 불과 한 달이라는 짧은 기간 내에 광고 완성을 목표로, 아이디어 구상부터 실제 영상의 일부 장면 제작까지 생성 AI를 적극 활용했는데, 그 결과, 전통적인 방식 대비 시간과 비용을 무려 90%나 절감하는 성과를 거두었어요. 과거라면 상상하기 어려웠을 효율성이에요. 더욱 주목할 만한 사실은, 해당 광고가 약 3개월간 공개되었음에도 AI가 사용되었다는 점을 대중이 거의 인지하지 못했어요.

물론 이 과정이 마냥 순탄했던 것은 아니에요. 원하는 결과물을 얻기 위해 수천 개의 프롬프트를 입력하고 수정하는 지난한 과정을 거쳤고, AI 특유의 '환각 현상(결과물의 오류나 비논리성)'으로 인해 결과물을 보정해야 하는 경우도 발생했어요. 특히, 키보드를 타이핑하는 손의 클로즈업 장면처럼 복잡하고 정교한 표현은 AI만으로는 한계가 있어 실사 촬영을 병행했다고 설명했어요.

이번 프로젝트를 담당한 MS의 제인 탠 시니어 디자인 매니저는 "결국 얼마나 끈질기게 노력하는 데에서 결과가 비롯된다"고 언급하며, AI 활용에 있어 인간의 창의성과 집요한 노력이 핵심적인 역할을 했음을 강조했어요.

AI를 활용한 실제 광고

AI는 이미 신입 프로그래머

AI 기술 발전 속도가 정말 놀랍지 않으신가요? 최근 MS의 사티아 나델라(Satya Nadella) CEO가 흥미로운 이야기를 전했어요. 메타(Meta)의 컨퍼런스에서 마크 저커버그(Mark Zuckerberg) CEO와 대담을 나누던 중, MS 내부 코드의 20%-30%가 이미 AI에 의해 작성되고 있다고 밝혔어요.

물론, 언어마다 성과는 조금씩 달라요. 파이썬 같은 언어에서는 AI의 기여도가 높지만, C++ 같은 경우는 아직 상대적으로 낮다고 해요. 하지만 마이크로소프트의 CTO는 더욱 놀라운 예측을 내놓았는데, 2030년까지 전체 코드의 95%가 AI에 의해 생성될 것이라고 전망했어요.

흥미로운 점은, 저커버그는 메타의 AI 코드 생성 비율을 아직 파악하지 못했다고 답했어요. 반면, 경쟁사인 구글의 순다르 피차이(Sundar Pichai) CEO는 최근 실적 발표에서 구글(Google) 코드의 30% 이상이 AI에 의해 생성되고 있다고 언급했어요.

다만 여기서 한 가지 짚고 넘어가야 할 점이 있어요. MS나 구글 모두 'AI 생성 코드'를 정확히 어떤 기준으로 측정하고 있는지는 명확히 밝히지 않았어요. 따라서 이 수치들은 AI의 코드 작성 능력이 빠르게 발전하고 있다는 중요한 신호로 받아들이되, 그 정확한 비율에 대해서는 조금 신중하게 접근할 필요가 있어 보여요. 앞으로 개발 문화와 환경이 어떻게 변화할지 주목해야 할 시점이에요.

업그레이드!

기존의 비트넷(BitNet b1.58)은 모델 가중치를 극단적으로 낮은 비트(1.58비트)로 줄여 메모리 효율성을 높이는 데 성공했어요. 하지만 중요한 부분인 '활성화(activation)' 값은 여전히 8비트로 처리했어요. 바로 활성화 값 분포에 존재하는 '이상치(outlier)', 즉 평균에서 크게 벗어난 값들 때문이에요. 이 이상치들은 낮은 비트(가령 4비트)로 정보를 압축하는 양자화 과정을 어렵게 만들었고, 모델의 성능 저하나 효율성 저하로 이어질 수 있었어요.

업그레이드 된 비트넷 v2(BitNet v2)는 이 문제를 해결하기 위해 H-BitLinear라는 새로운 아이디어를 사용했어요. 핵심은 활성화 값을 양자화하기 직전에 '하다마드 변환(Hadamard Transformation)'이라는 수학적 기법을 적용하는 것이라네요.

결과는 놀라웠어요. 새로운 비트넷은 8비트 활성화를 사용했을 때 기존 비트넷과 동등한 성능을 유지했어요. 더 나아가, 네이티브 4비트 활성화를 사용하도록 직접 학습시켰을 때도 성능 저하가 거의 없었어요. 이 덕에 앞으로 비트넷을 쓰면 최신 하드웨어가 지원하는 4비트 계산 능력을 온전히 활용할 수 있는 길이 열린 셈이라네요.

MS판 딥시크!

MS에서 그동안 개발해온 Phi 시리즈의 최신 AI인 'Phi-4-reasoning'과 'Phi-4-reasoning-plus'를(이하 '파이-4 추론') 공개했어요. 이들은 140억 파라미터(14B)라는 비교적 작은 크기에도 불구하고 복잡한 추론 작업에서 강력한 성능을 보여주는 모델들이에요.

'파이-4추론'은 기존 파이-4(Phi-4) 모델을 기반으로, 엄선된 '가르치기 좋은(teachable)' 프롬프트와 상세한 추론 과정을 담은 데이터를 활용한 지도 미세조정(SFT)을 통해 학습되었습니다. 여기서 더 나아가 '파이-4 추론 플러스'는 딥시크 R1처럼 강화학습(RL) 단계를 추가해서 특히 수학에서 더 높은 정확도를 달성했어요.

주목할 점은 이 모델들의 성능인데, 수학, 과학적 추론, 코딩, 알고리즘 문제 해결 등 다양한 벤치마크에서 훨씬 큰 AI 모델들을 능가하는 결과를 보여줬어요. 심지어 일부 벤치마크에서는 671B 파라미터 규모의 딥시크 R1(DeepSeek-R1) 모델에 근접하는 성능을 나타내기도 했어요. 놀라운 점은, 특정 추론 영역뿐 아니라 일반적인 언어 이해 능력 벤치마크에서도 기존 파이-4 대비 상당한 성능 향상을 보였어요.

이는 딥시크가 딥시크 R1을 통해서 공개한 AI 개발 레시피가 유효하다는 점을 보여줘요. 앞으로도 누구나 쓸 수 있는 똑똑하고 가벼운 모델이 더 늘어나면 좋겠네요.

AI도 특허로!

구글 딥마인드(Google DeepMind)에서 최신 AI 특허 기술을 발표했어요. 특허는 기존 신경망 모델을 처음부터 다시 학습할 필요 없이, 점진적으로 네트워크를 확장하면서 이전의 학습 성과를 그대로 유지하는 혁신적인 방법을 제시하고 있어요.

예를 들어, 트랜스포머(Transformer) 기반 모델과 같이 대규모 모델을 훈련할 때 발생하는 높은 계산 비용과 긴 학습 시간을 극복할 수 있도록, 새로운 구성 요소를 추가할 때 제로 초기화 등의 특별한 기법을 적용해 네트워크의 기능이 즉시 그대로 보존되도록 해요.

이러한 ‘function-preserving expansion’ 접근 방식은 단계별 확장을 가능하게 돕고, 기존 모델의 성능 저하 없이 추가 학습을 진행할 수 있다는 점에서 큰 장점을 가지고 있어요. 앞으로 인공지능 모델의 효율성과 확장성 측면에서 새로운 방향을 제시할 이 기술이 AI 분야에 신선한 변화를 불러일으킬 것으로 기대돼요.

뒤를 바싹

최근 구글에서 제미나이(Gemini)를 담당하는 로건 킬패트릭(Logan Kilpatrick)의 소식에 따르면, 구글 AI 스튜디오(Google AI Studio)와 제미나이 API의 활성 사용자가 올해 초부터 200% 이상 늘었다고 해요. 특히 제미나이 2.5 Pro 덕분이라는 설명이 인상적이었는데, AI 서비스 이용이 한층 더 활발해진 상황을 실감할 수 있어요.

한편 일론 머스크(Elon Musk)는 X를 통해 다음 주 슈퍼그록(SuperGrok) 구독자 전용으로 그록 3.5(Grok 3.5) 초기 베타 버전을 출시한다고 발표했어요. 그록 3.5는 기존에 찾기 힘든 로켓 엔진이나 전기화학처럼 전문적인 질문들에 대해 첫 원칙을 기반으로 정교하게 답변할 수 있다고 해요.

이처럼 인터넷에 존재하지 않는 새로운 답변을 제시할 수 있다는 점은 AI 기술의 한계를 넘어서고 있다는 증거에요. 이미 이전 버전 이후 그록 공식 앱의 모바일 다운로드 수가 10배나 증가하고, 이용자 수 역시 급격히 늘어났다는 소식은 많은 이들에게 큰 기대감을 안겨주고 있어요.

Next week, Grok 3.5 early beta release to SuperGrok subscribers only.

— Elon Musk (@elonmusk) April 29, 2025

It is the first AI that can, for example, accurately answer technical questions about rocket engines or electrochemistry.@Grok is reasoning from first principles and coming up with answers that simply don’t… https://t.co/T1mpHromMw

명령하는 근육

AI 발전 속도는 경이로워요. 단 한 개의 데이터로도 추론 능력을 비약시키고(원샷 RLVR), 비트넷 v2 같은 혁신으로 효율성도 극대화되고 있어요. MS Phi-4 추론, Grok 3.5는 기존 정보 너머 새로운 추론까지 해내요. MS 광고처럼 90% 시간/비용 절감 사례와 MS·구글 코드 20-30% 이상 AI 작성은 이미 현실이에요.

특히 저커버그는 내년 개발 절반을 AI가 맡고 개발자는 'AI 에이전트 리더'가 될 거라 예측, 직무 변화를 시사했어요. 나델라는 기술보다 사회 변화가 느릴 수 있다지만, AI가 업무를 근본적으로 재편할 거라는 전망엔 모두 동의하고 있어요. 이제, 돌이킬 수 없는 변화를 받아들이고 에코 멤버님들이 주도하는 인간의 역할 재정의가 필요한 시점이에요.

Cinnamomo di Moscata (글쓴이) 소개

게임 기획자입니다. https://www.instagram.com/cinnamomo_di_moscata/

(1) arXiv:2504.20571 [cs.LG]

(2) 임대준. (2025). MS, 생성 AI로 광고 제작...3개월간 아무도 눈치 못 채. AI타임스. https://www.aitimes.com/news/articleView.html?idxno=170020

(3) Maxwell Zeff. (2025). Microsoft CEO says up to 30% of the company’s code was written by AI. TechCrunch. https://techcrunch.com/2025/04/29/microsoft-ceo-says-up-to-30-of-the-companys-code-was-written-by-ai

(4) arXiv:2504.18415 [cs.CL]

(5) Marah Abdin, Sahaj Agarwal, Ahmed Awadallah, Vidhisha Balachandran, Harkirat Behl, Lingjiao Chen, Gustavo de Rosa, Suriya Gunasekar, Mojan Javaheripi, Neel Joshi, Piero Kauffmann, Yash Lara, Caio César Teodoro Mendes, Arindam Mitra, Besmira Nushi, Dimitris Papailiopoulos, Olli Saarikivi, Shital Shah, Vaishnavi Shrivastava, Vibhav Vineet, Yue Wu, Safoora Yousefi, Guoqing Zheng. (2025). Phi-4-reasoning Technical Report. Microsoft. https://www.microsoft.com/en-us/research/wp-content/uploads/2025/04/phi_4_reasoning.pdf

(6) SETI Park. (2025). "Composable Function-Preserving Expansion of Neural Networks for Efficient Continual Training @GoogleDeepMind's US20250131254A1 patent application introduces a novel framework for efficiently training increasingly large neural networks (NNs), particularly Transformer-based https://t.co/Nvus3pvbVT". X. https://x.com/seti_park/status/1917077768015384878

(7) Logan Kilpatrick. (2025). "Active users in Google AI Studio and the Gemini API have grown over 200% since the beginning of this year, driven by 2.5 Pro 🤯 This is just the beginning…". X. https://x.com/OfficialLoganK/status/1917356639952191848

(8) Elon Musk. (2025). "Next week, Grok 3.5 early beta release to SuperGrok subscribers only. It is the first AI that can, for example, accurately answer technical questions about rocket engines or electrochemistry. @Grok is reasoning from first principles and coming up with answers that simply don’t". X. https://x.com/elonmusk/status/1917099777327829386

(9) 윤민혁. (2025). 매년 10% 해고하는 저커버그 "내년 AI가 개발자 절반 대체" [윤민혁의 실리콘밸리View]. 서울경제. https://n.news.naver.com/article/011/0004480271

![2026년 2월, '비서' AI는 죽었습니다: Claude 4.6이 불러온 1인 유니콘의 시대 [오디오 지원]](/content/images/size/w1272/2026/02/----------------1.png)