GEN AI INNOVATION 2024 후기

안녕하세요. 부루퉁입니다. 개인사정이 있어 지난 10월 4일 양재 aT센터에서 진행된 GEN AI 2024 후기 글 이제서야 올립니다. 이번에 진행된 AI 컨퍼런스는 국내 최초로 시민과 AI 전문가들이 함께한 자리로 글로벌 AI 기술과 활용 방법에 대해 배울 수 있었습니다. 주요 연사로는 AI 코리아 커뮤니티의 수장 보표님과 이한준 STACKERS 대표, 정호영 ZEXEA 대표,

끝없는 AI 기술 발전과 에너지 소비 문제

OpenAI o1의 등장과 함께 AI 기술은 빠른 속도로 발전하고 있습니다. 2030년에는 현재보다 1만 배나 큰 규모의 AI 모델이 등장할 수 있다는 전망까지 나오고 있습니다. 인공지능의 발전은 새로운 가능성을 열어주지만, 동시에 해결해야 할 많은 문제도 있습니다. 가장 큰 문제는 전력과 자원의 소모입니다. 전력 소비의 문제 최근 AI 모델의 훈련은 엄청난 전력을

SKT, AI 개인비서 '에이닷' 3.0 업데이트 챗GPT, 클로드 등 멀티 LLM 지원

SKT의 AI 대화형 서비스 ‘에이닷’이 8월 26일 대규모 3.0 업데이트를 통해 똑똑한 AI 개인비서로 재탄생했습니다. 이번 업데이트는 특히 ‘데일리’와 ‘멀티 LLM’, ‘전문 에이전트’ 기능이 추가돼 사용자의 편의성을 크게 향상시켰습니다. 각각의 기능을 하나씩 함께 알아보겠습니다. 에이닷은 사용자에게 일정을 등록하거나 관리할 수 있도록 돕는 ‘데일리’ 기능을 제공합니다. 기존 에이닷에

대규모 업데이트로 AI 개인비서가 된 에이닷!!

SKT의 대화형 AI 에이닷은 프렌즈, 대화방, 챗T 등 챗봇 기능을 제공하고 있었습니다. 에이닷은 8월 26일 대규모 3.0 업데이트를 진행하면서 AI 개인비서로 재탄생했는데요. 이번 업데이트의 가장 큰 특징인 데일리 기능과 멀티 LLM 기능, 미디어·뮤직·증권·영화예매 등 다양한 에이전트(비서) 기능에 대해 자세히 알아보겠습니다. 에이닷 데일리 에이전트 에이닷에 일정

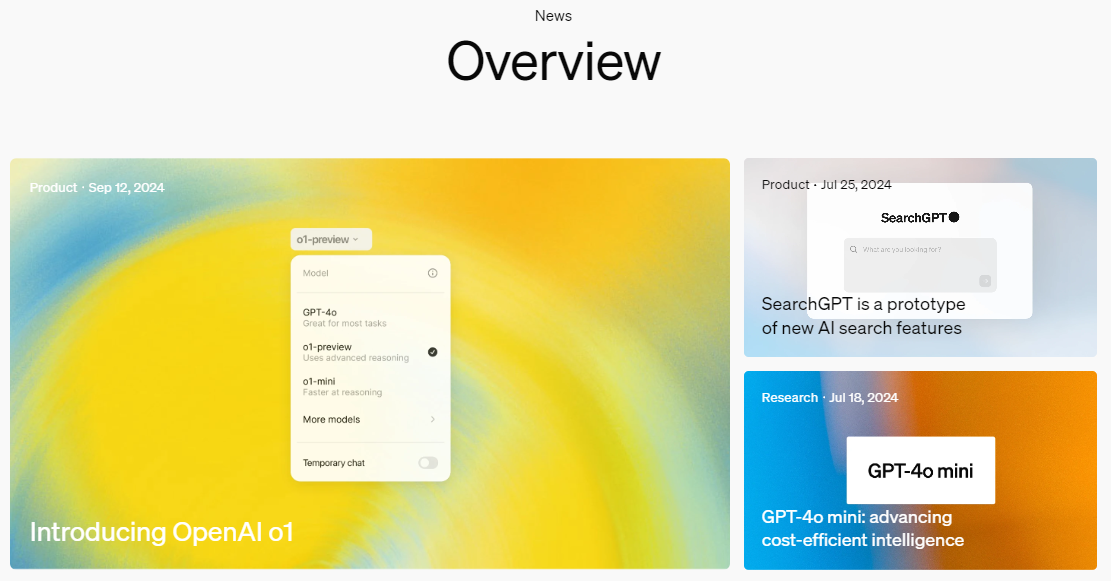

OpenAI o1-preview 소개 및 작동원리

안녕하세요. 에코 뉴스레터 구독자님들 뉴스레터 작가 부루퉁입니다. 추석연휴가 끝나가기도 하고, 인사도 드릴겸, 편하고 친근한 스타일로 뉴스레터를 작성해 볼까 합니다. OpenAI o1-preview에 대해 에코 편집장이신 보표님께서 한글 자막 유튜브 영상을 만들어 주셨지만, 글로 정리해 둔 것도 있으면 좋을 것 같아 o1-preview 소개 및 작동원리에 대해 정리해 보려 합니다. (보표님께서 만드신 유튜브

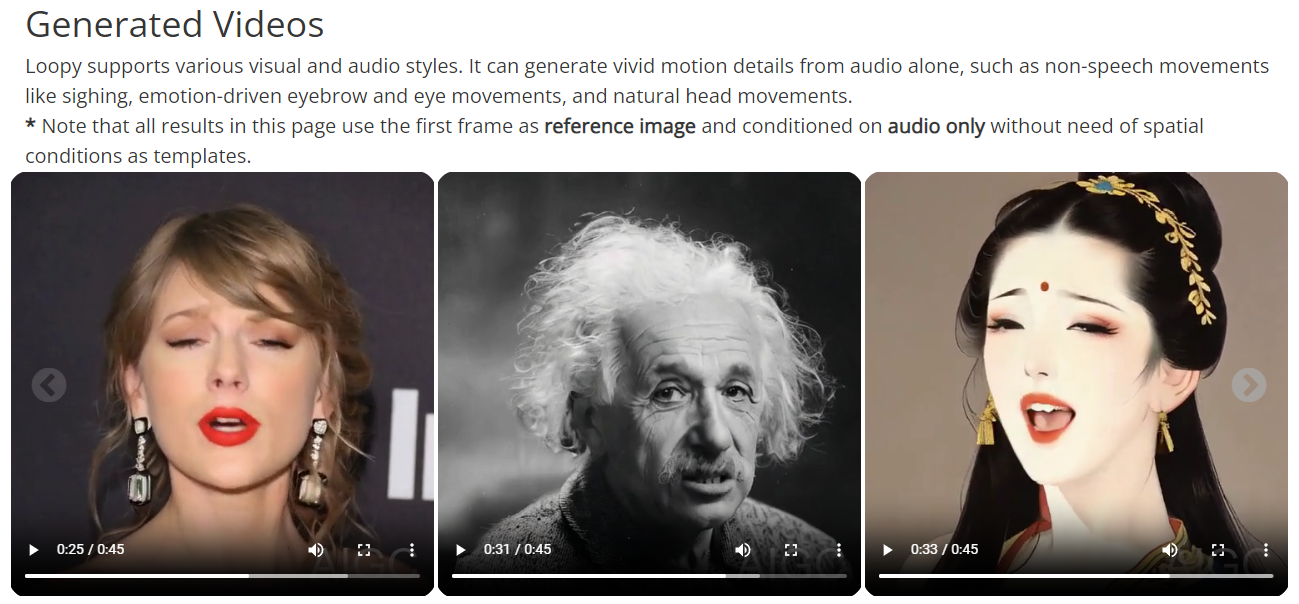

오디오 기반 얼굴, 립싱크 비디오 생성AI, Loopy 공개

틱톡을 서비스하고 있는 중국의 IT기업 바이트댄스와 절강대학이 오디오 기반의 얼굴 모션 생성AI, Loopy를 공개했습니다. 기존의 오디오 기반 비디오 생성 모델은 얼굴의 위치나 각도 같은 정보를 바탕으로 움직임을 만들어내는 방식이었습니다. 하지만 이 방식은 다양한 각도와 동작을 자연스럽게 표현하는 데 한계가 있었는데요. Loopy는 이런 공간적 정보 없이도 오디오 신호만으로 자연스럽고 현실감 있는

지푸AI 영상 생성 오픈 소스 Cog Video X 공개, 데모 사용방법

지푸AI(Zhipu AI)의 영상 생성 AI가 오픈소스로 공개되었습니다. 런웨이의 Gen-3, Luma ai의 드림머신, 오픈AI의 SORA 등 독점 영역이었던 영상 생성 모델을 이제 누구나 활용할 수 있게 되었습니다. 중국의 대표 AI 스타트 기업 중 하나인 지푸AI(Zhipu AI)는 앞서 '코그비디오'와 '릴레이 디퓨전' 등 자체

텍스트와 이미지 생성의 끝판왕 ideogram 2.0 등장! 성능은? (미드저니, Flux, Dall-E3 비교)

24년 8월 21일 Ideogram 2.0이 모든 사용자에게 무료로 공개되었습니다. Ideogram은 타이포그래피와 텍스트 생성에서 강점을 보여주고 있던 이미지 생성 AI였는데, 이번 2.0 업데이트를 계기로 이미지 생성 AI의 끝판왕으로 불리게 되었습니다. Ideogram 2.0은 실사에 가까운 이미지에 더해 자연스러운 텍스트까지 생성할 수 있어 최근 이용자들에게 호평을 받고 있습니다. 기본적인 텍스처가

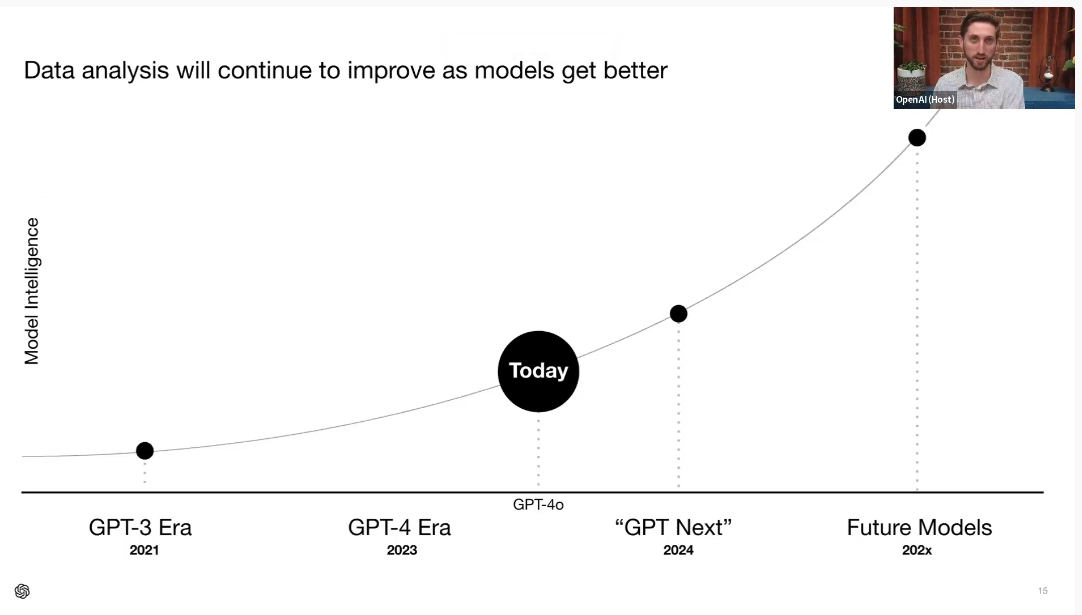

오픈AI의 다음 모델은 GPT-5? GPT-Next?, 챗GPT 무료 이용자 DALL-E3 사용가능

8월 9일 오픈AI 공식 홈페이지에 올라 온 ChatGPT Enterprise를 활용한 데이터 분석 영상 말미에 GPT 모델 출시에 관련된 그래프가 공개되었습니다. 그래프를 살펴보면 현재 GPT-4o의 위치와 다음 모델이 2024년에 GPT-Next로 출시할 예정인 것을 확인할 수 있습니다. 2023년 5월 비공식 프레젠테이션에서 공개된 그래프와 비슷한 모양입니다. 오픈AI가 올해 DevDay에서 새 모델을 발표하지 않을

이미지 생성 모델의 신흥 강자 Flux.1 Dev 데모 사용방법 및 후기

현재 이미지 생성AI의 양대산맥은 누가 뭐라해도 미드저니와 Stable Diffusion 3-Ultra입니다. 하지만 최근 Black Forest Labs가 개발한 Flux.1 모델의 벤치마크가 미드저니와 SD3-Ultra를 넘어선 것으로 알려졌습니다. 사용자가 입력한 프롬프트에 대한 모델의 반응 정확도와 다양한 크기, 비율로 생성할 수 있는 능력, 퀄리티, 타이포그래피 등에서 Flux.1 Pro와 Dev는 높은 성능을 보여주는 것을

Meta Llama 3.1 성능 비교 및 사용방법

4050억 개의 매개변수를 가진 LLM 오픈 소스 llama 3.1을 메타가 공개했습니다. 이번에 공개한 llama 3.1은 오픈AI의 GPT-4o와 앤트록픽의 Claude 3.5 Sonnet과 비슷한 성능을 자랑하고 있습니다. llama 3.1 405B의 벤치마크 결과만 봐도 얼마나 대단한 모델인지 확인이 가능합니다. MMLU(지식)부분도 GPT-4o, Claude 3.5 Sonnet과 큰차이가 나지

Transformer의 한계를 극복할 TTT(Test Time Training) 아키텍처

AI모델의 성능을 높이기 위해 많은 연구가 진행되고 있습니다. 현재 대다수의 생성형 AI는 Transformer 아키텍처를 활용해 개발되었지만, 데이터의 크기가 커질수록 추론 속도가 느려지고, 메모리와 전력 소모가 많아지는 단점이 있습니다. 이에 대한 대안으로 스탠포드대학교, UC샌디에고, UC버클리, 메타 연구진들이 새로운 아키텍처인 'TTT(Test Time Training)'를 개발했습니다. 기존 Transformer의 단점을 보완하면서,