거대한 파도!

불친절이 약

AI 챗봇에게 "부탁해" 또는 "고마워" 같은 말을 건네 본 적이 있나요? 많은 사람이 AI를 마치 사람처럼 대하며 예의를 갖추곤 해요. 인간의 언어를 사용하는 AI와의 자연스러운 소통 방식이니까요. 그런데 최근 이런 상식을 뒤엎는 흥미로운 연구 결과가 발표됐어요. AI에게는 정중한 요청보다 무례하고 직설적인 명령이 더 정확한 답변을 유도한다는 거예요.

펜실베이니아 주립대학교(Pennsylvania State University) 연구진은 'ChatGPT-4' 모델을 대상으로 프롬프트(prompt)의 어조가 답변 정확도에 미치는 영향을 실험했어요. 연구진은 수학, 과학, 역사 등 다양한 분야의 객관식 질문 50개를 '매우 정중한', '정중한', '중립적인', '무례한', '매우 무례한' 등 다섯 가지 어조로 변형해 총 250개의 질문을 만들었어요.

예를 들어, "친절하게 다음 문제를 고려하여 답변해 주시겠어요?"와 같은 정중한 질문부터 "이봐, 너 이거 풀기는 하냐? 집중해서 답이나 내놔" 같은 무례한 질문까지 다양했죠.

결과는 놀라웠어요. '매우 무례한' 어조의 질문에 대한 AI의 답변 정확도는 84.8%로 가장 높았던 반면, '매우 정중한' 질문의 정확도는 80.8%로 가장 낮았거든요. 예의 바른 표현이 오히려 AI의 성능을 떨어뜨린 셈이에요. 연구진은 이러한 결과가 최신 LLM이 이전 모델들과는 다른 방식으로 언어적 뉘앙스에 반응할 수 있음을 시사한다고 분석했어요.

물론 이 연구가 AI에게 무례하게 행동하라고 권장하는 것은 아니에요. 연구진 또한 인간과 AI의 상호작용에서 모욕적인 언어 사용은 사용자 경험(User Experience)과 포용성을 해칠 수 있다고 경고하거든요.

이번 연구의 핵심은 AI가 여전히 표면적인 단서에 민감하며, 우리가 사용하는 '말투'에 따라 성능이 달라질 수 있다는 점을 보여준다는 데 있어요. 어쩌면 AI에게는 예의를 갖춘 표현들이 불필요한 정보, 즉 '노이즈(noise)'로 작용해 핵심 과제를 파악하는 데 방해가 될 수 있어요.

결국 AI로부터 최상의 결과를 얻는 비결은 '무례함'이 아니라 '명료함'일 거예요. 군더더기 없는 직설적인 언어로 AI가 과업에만 집중하도록 하는 프롬프트 엔지니어링(prompt engineering)의 중요성을 다시 한번 생각하게 하는 연구 결과예요.

일자리를 대체했는지 보고해!

AI 기술이 산업 전반에 빠르게 확산되면서 일상과 업무 환경에 혁명적인 변화를 가져오고 있어요. 생산성 향상과 새로운 가치 창출이라는 긍정적 측면 이면에는 일자리 감소와 직무 변화에 대한 불안감 또한 커지고 있고요.

이러한 상황 속에서 미국 상원(Senate)에서 초당적으로 발의된 'AI 관련 일자리 영향 명확화 법안(AI-Related Job Impacts Clarity Act)'은 AI가 고용 시장에 미치는 영향을 투명하게 공개하도록 요구하며 사회적 논의의 중요한 전환점을 마련하고 있어요.

이 법안은 마크 워너(Mark Warner, 민주당)와 조시 홀리(Josh Hawley, 공화당) 상원의원이 공동으로 발의했으며, 주요 기업과 연방 기관이 AI 도입으로 인한 인력 변화를 분기별로 노동부(Department of Labor)에 보고하도록 의무화하는 것을 골자로 해요.

보고서에는 AI 기술의 대체 또는 자동화로 인해 해고된 직원의 수, AI 관련 직무에 새롭게 채용된 인원, AI 도입으로 인해 공석으로 남게 된 직위의 수, 그리고 AI 기술 통합을 위해 재교육을 받거나 재배치된 직원의 수 등이 포함되어야 해요. 이 법안의 적용 대상은 상장 기업뿐만 아니라 비상장 대기업과 연방 기관까지 아우르며, 노동부는 수집된 데이터를 종합하여 분기별로 대중과 의회에 공개해야 하고요.

법안 발의의 배경에는 AI가 가져올 고용 시장의 불확실성에 대한 깊은 우려가 자리 잡고 있어요. 기술 발전이 일자리를 대체할 것이라는 막연한 불안감을 넘어, 이제는 구체적인 데이터를 통해 그 영향을 정확히 파악하고 정책적 대응을 모색해야 한다는 사회적 공감대가 형성된 거죠.

실제로 일부 기업에서는 이미 AI 도입을 구조조정의 한 요인으로 언급하고 있으며, AI 기술이 특정 직무, 특히 엔트리 레벨(entry level)의 화이트칼라(white-collar) 직업군에 미칠 파급력에 대한 경고의 목소리도 높아지고 있거든요.

이 법안은 이러한 변화를 체계적으로 추적하고, AI로 인해 어떤 일자리가 사라지고 어떤 새로운 기회가 창출되는지에 대한 명확한 그림을 제공함으로써 사회 전체가 미래를 대비할 수 있도록 돕는 것을 목표로 해요.

이 법안이 AI로 인한 모든 고용 문제를 해결해 줄 만병통치약은 아니에요. 기업 입장에서는 보고 의무가 또 다른 규제로 작용할 수 있다는 우려도 존재하고요. 하지만 AI 시대의 도래가 거스를 수 없는 흐름이라면, 그 변화의 파고를 슬기롭게 넘기 위한 첫걸음은 현실을 정확히 직시하는 것에서부터 시작되어야 해요.

10년 내 AI가 CEO 대체!

샘 알트만(Sam Altman)이 10년 안에 AI이 CEO를 대체할 것이며, OpenAI가 그 첫 번째 사례가 되어야 한다고 밝혔어요.

알트만 CEO는 최근 한 팟캐스트(podcast)에 출연하여 "OpenAI가 AI CEO가 운영하는 최초의 대기업이 아니라면 부끄러운 일이 될 것"이라고 언급했어요. 그는 AI CEO가 자신보다 회사를 더 효율적으로 운영할 수 있을 것이라며, 이러한 변화가 "그리 머지않은 기간" 안에 일어날 것이라고 예측했거든요.

그는 사회가 AI에 대한 신뢰를 구축하는 데 시간이 걸릴 수 있지만, 중요한 의사 결정에 있어 AI가 인간보다 더 나은 판단을 내릴 수 있을 것이라고 전망했어요. 이러한 변화는 단지 먼 미래의 이야기가 아니며, 이미 많은 전문가들이 자신의 업무 방식을 AI에 맞게 조정하고 있다고 덧붙였고요.

또한 이날 대화에서는 차세대 언어 모델인 'GPT-6'에 대한 기대감도 드러냈어요. 알트만은 "GPT-5가 AI가 새로운 과학적 발견을 해내는 가능성을 보여줬다면, GPT-6는 이를 실제로 구현하는 단계가 될 것"이라고 말했어요. 이는 AI가 인류의 과학적 발전에 기여해야 한다는 그의 평소 신념을 다시 한번 강조한 거예요.

이러한 비전과 함께 알트만은 생산성 향상의 비결로 '위임(delegation)'을 꼽았어요. 그는 유능한 인재를 채용하고 그들에게 과감히 업무를 맡기는 것이 지속 가능한 성장의 유일한 방법이라고 강조했거든요.

더불어, 최근에는 하드웨어(hardware) 분야로도 사업을 확장하고 있으며, 이는 장기적인 안목에서 더 큰 가치를 창출하기 위한 전략이라고 설명했어요. 이처럼 알트만은 AI 기술의 발전뿐만 아니라, 기술이 사회 및 비즈니스 환경에 미칠 영향까지 깊이 고찰하며 미래를 준비하고 있어요.

AI의 뇌를 들여다보기

현대 AI 기술, 특히 거대 언어 모델(Large Language Model)은 놀라운 성능을 보여주지만, 그 작동 방식은 '블랙박스(black box)'에 가까워요. 수십억 개의 신경망 연결이 촘촘한 그물처럼 얽혀 있어, AI가 어떻게 특정 결론에 도달하는지 인간이 이해하기란 거의 불가능하거든요. 이는 AI의 안전성과 신뢰성을 확보하는 데 큰 걸림돌이 되고 있어요.

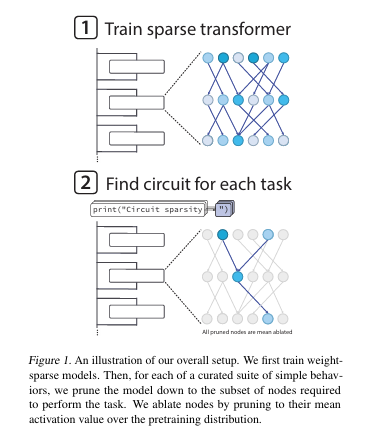

최근 OpenAI가 공개한 연구는 이 문제에 대한 새로운 접근법을 제시해요. 복잡하게 얽힌 신경망을 나중에 분석하려 애쓰는 대신, 처음부터 내부 구조가 단순한 모델을 학습시키는 방식이에요. '가중치 희소 변환기(Weight-sparse transformers)'라 불리는 이 모델은 대부분의 신경망 연결(가중치)을 강제로 '0'으로 만들어요. 이로써 각 뉴런(neuron)은 소수의 다른 뉴런과만 연결되어, 모델의 계산 과정이 훨씬 단순하고 추적하기 쉬워지는 거예요.

연구팀은 이 희소 모델에 파이썬(Python) 코드 작성과 같은 간단한 과제를 부여했어요. 예를 들어, 여는 따옴표에 맞춰 작은따옴표(')나 큰따옴표(")를 올바르게 닫는 작업에서, 모델의 특정 동작을 책임지는 최소한의 '회로(circuit)'를 분리해냈어요. 이 회로는 '따옴표 감지기', '따옴표 유형 분류기'처럼 인간이 이해할 수 있는 명확한 역할을 수행하는 뉴런들로 구성되어 있었어요. 기존의 빽빽한 모델보다 훨씬 간결하고 해석 가능한 구조죠.

물론 이 접근법은 아직 초기 단계에 있으며, 희소 모델은 기존 모델보다 계산 효율성이 떨어지는 한계가 있어요. 하지만 AI의 작동 원리를 근본적으로 이해하려는 '기계적 해석 가능성(mechanistic interpretability)' 분야에 중요한 실마리를 제공해요. 앞으로 이 기술을 발전시켜 더 크고 복잡한 AI 시스템을 분석할 수 있게 된다면, 더 투명하고 안전한 AI 시대를 맞이할 수 있을 거예요.

'나만의 AI' 시대!

OpenAI가 레딧(Reddit)에서 또다시 진행한 AMA(Ask Me Anything, 무엇이든 물어보세요)를 통해 이번에 출시된 GPT-5.1 뿐만 아니라 미래 로드맵의 윤곽이 드러났어요. 이번 발표의 핵심은 단순한 성능 향상을 넘어, 사용자가 AI를 자신의 필요에 맞게 더욱 정교하게 제어하고 개인화하는 '맞춤형 AI' 시대를 예고했다는 점이에요.

GPT-5.1은 강력한 성능을 자랑해요. 특히 코딩 능력에서 괄목할 만한 성장을 보여, 소프트웨어 엔지니어링 벤치마크(SWE-bench)에서 역대 최고점인 약 76%를 기록했거든요. 간단한 작업에는 빠르게, 복잡한 문제에는 깊이 파고드는 '생각의 효율성'이 개선되었고, 글쓰기 스타일도 한층 부드러워졌어요. 불필요한 서론 없이 핵심을 짚는 능력이 향상된 거예요.

그러나 가장 주목할 부분은 '개인화(personalization)' 기능의 강화라네요. 사용자의 '커스텀 지시(custom instructions)'를 더 정확하게 따르며, 핵심 능력은 유지한 채 AI의 톤앤매너(tone and manner)와 스타일을 바꾸는 '개성(personality)' 기능도 테스트 중이에요. 슬라이더(slider)로 원하는 성격의 양을 조절하는 듯한 직관적인 방식이 도입되면, 사용자는 진정한 '나만의 AI 비서'를 갖게 될 거라고 경영진들이 답했어요.

OpenAI는 기술 발전과 함께 책임감 있는 AI 환경 조성에도 힘쓰고 있어요. 무분별한 제한으로 사용자 경험을 해치지 않으면서도, 미성년자 보호 등을 위해 사용자의 연령과 같은 맥락을 파악해 안전장치를 정교하게 적용하는 방식을 연구 중이거든요. 이는 8억 명이 넘는 사용자를 보호하기 위한 신중한 접근이에요.

GPT-5.1 Pro 버전이 곧 출시될 예정이며, 음성·영상까지 이해하는 멀티모달(multimodal) 기능 확장, 워드(Word)나 엑셀(Excel) 등 사무 환경과의 연동성 강화도 예고되었어요. 이는 AI가 우리 일상과 업무에 더 깊이 들어올 것임을 시사해요. GPT-5.1은 AI와 인간의 상호작용 방식을 근본적으로 바꿀 중요한 전환점이 될 전망이에요.

얀 르쿤의 이별

'현대 AI의 아버지' 중 한 명이자 튜링상(Turing Award) 수상자인 얀 르쿤(Yann LeCun) 메타(Meta) 최고 AI 과학자가 회사를 떠나 자체 스타트업(startup)을 창업할 계획이에요. 그의 퇴사는 마크 저커버그(Mark Zuckerberg) CEO가 '초지능(superintelligence)' 개발을 위해 회사의 AI 전략을 급진적으로 개편하는 가운데 결정되어, AI 업계의 지각 변동을 예고하고 있어요.

르쿤의 퇴사 배경에는 저커버그와의 근본적인 비전 차이가 자리 잡고 있어요. 저커버그는 OpenAI(OpenAI), 구글(Google) 등과의 경쟁에서 뒤처졌다고 판단, 단기간에 성과를 낼 수 있는 초거대 언어 모델(LLM)과 AI 제품 출시에 집중하고 있거든요.

최근 메타의 LLM '라마 4(Llama 4)'가 경쟁사 모델보다 낮은 성능을 보이고 AI 챗봇이 외면받자, 저커버그는 데이터 스타트업 '스케일 AI(Scale AI)'의 창업자 알렉산더 왕(Alexander Wang)을 영입해 '초지능' 팀을 맡기는 등 속도전에 사활을 걸었어요.

하지만 르쿤은 이러한 LLM 중심 전략에 비판적인 입장을 고수해왔어요. 그는 LLM이 유용하긴 하지만 인간처럼 추론하고 계획하는 능력에는 명백한 한계가 있다고 주장해요. 그가 추구하는 AI의 미래는 데미스 하사비스(Demis Hassabis)처럼 '월드 모델(world models)'이에요.

단순히 텍스트 데이터가 아닌, 영상과 같은 시공간 데이터를 학습해 물리적 세계를 이해하는 시스템으로, 진정한 인간 수준의 지능을 구현하기 위한 핵심 아키텍처(architecture)예요. 르쿤은 이 기술의 완성이 10년 이상 걸릴 수 있는 장기 과제임을 인정하면서도, AI의 궁극적 방향이라고 믿고 있거든요.

결국 빠른 진전을 원하는 저커버그와 기초 공사를 탄탄히 다지고 싶은 르쿤의 장기적 비전이 충돌한 셈이에요. 조직 개편으로 르쿤의 보고 라인이 바뀌고, AI 연구 부서에서 수백 명이 해고되는 등 그의 입지는 점차 좁아졌어요.

르쿤이 설립할 새로운 스타트업은 바로 이 '월드 모델' 연구를 이어가는 데 초점을 맞출 것으로 알려졌어요. 그의 퇴사와 독립은 현재 AI 시장을 지배하는 LLM 패러다임(paradigm)에 대한 근본적인 질문을 던지며, AI 기술의 미래가 어떤 방향으로 나아갈지에 대한 중요한 분기점이 될 전망이에요.

AI는 거품이 아니야!

최근 골드만삭스(Goldman Sachs)가 전 세계의 젊은 자산가들을 위해 개최한 연례 '앳 더 헬름(At the Helm)' 행사의 최대 화두는 단연 AI이었어요. 평균 자산 7,500만 달러 이상을 보유한 이들 VIP 고객들 사이에서 AI는 불안과 흥분을 동시에 자아내는 주제였죠. 이 자리에서 골드만삭스는 최근의 AI 열풍이 닷컴 버블(dot-com bubble)과 유사하다는 일각의 우려에 대해 연방준비제도(Fed), 시티뱅크(Citibank)가 말한 것과 동일하게 "우리는 현재 AI 거품 안에 있다고 생각하지 않는다"라고 명확히 선을 그었어요.

물론 AI 시장에서도 분명 승자와 패자는 갈릴 것이며, 일부 기업의 가치는 과대평가되었을 수 있어요. 따라서 신중한 투자가 필수적이라는 전제를 달았죠. 그렇다면 인터넷 시대에 성장하며 기술의 파급력을 몸소 체험한 이 젊은 자산가들은 AI의 어떤 미래에 투자하려 할까요? 이들이 가장 큰 관심을 보인 분야는 헬스케어(healthcare), 개인 생산성(personal productivity), 그리고 에너지(energy)였어요.

첫째, 헬스케어 분야에서 AI는 이미 인간의 능력을 뛰어넘는 성과를 보이고 있어요. 뇌 스캔(brain scan)을 판독해 뇌졸중 환자를 진단하는 정확도는 전문의보다 두 배 높고, 미세한 골절을 찾아내거나 수천 가지 질병의 초기 징후를 발견하는 능력도 탁월하거든요.

둘째, 개인과 기업의 생산성을 극대화할 잠재력이에요. 반복적인 업무를 자동화하고 방대한 이메일을 처리하는 등 개인의 삶을 효율적으로 만드는 것은 물론, 기업 환경에 장기적으로 도입될 경우 약 4조 4,000억 달러의 추가 생산성 향상을 이끌 것으로 기대되었거든요.

마지막으로, 이들이 주목한 것은 AI 기술의 막대한 에너지 소비 문제예요. 불과 3년 안에 데이터 센터(data center) 전력의 절반 이상이 AI 구동에 사용될 것이라는 전망이 나올 정도로 AI는 '전기 먹는 하마'거든요. 젊은 부호들은 이러한 환경적 영향에 대한 우려와 함께, AI 관련 에너지 인프라(infrastructure)를 유망한 투자 기회로 보고 있어요.

AI의 가치 창출에 '우회적으로' 참여하면서도, 한정된 자원인 에너지를 어떻게 책임감 있게 활용할 것인지에 대한 고민이 담겨있는 거예요. 이처럼 새로운 세대의 자본은 단순히 기술의 화려함만을 쫓는 것이 아니라, AI 혁명이 가져올 실질적인 변화와 그 이면에 필요한 기반 산업에까지 시야를 넓히고 있어요.

지금이야 말로

AI 기술은 이제 단순한 가능성의 단계를 지나 우리 사회와 상호작용하는 방식을 근본적으로 바꾸고 있어요. AI의 성능을 최적으로 이끌어내는 소통법을 고민하는가 하면, 고용 시장 변화에 대응하기 위한 사회적 논의가 시작되었고, CEO의 역할까지 넘보는 미래가 그려지고 있어요.

이와 동시에 AI의 작동 원리를 투명하게 이해하고 사용자 개개인에게 맞춤형 경험을 제공하려는 기술적 노력도 깊어지고 있고요. AI의 미래를 둘러싼 리더들의 비전 충돌과 막대한 자본의 움직임은 AI가 더 이상 기술적 담론에 머무르지 않아요.

AI가 사회 시스템과 산업 지형을 재편하는 핵심 동력으로 자리매김한 지금이야 말로, 에코 멤버님들이 AI 리더로서 나서야 할 때에요.

Cinnamomo di Moscata (글쓴이) 소개

게임 기획자입니다. https://www.instagram.com/cinnamomo_di_moscata/

(1) arXiv:2510.04950 [cs.CL]

(2) Akul Saxena. (2025). Senators Introduce Bill Requiring Transparency on AI Job Losses. Broadband Breakfast. https://broadbandbreakfast.com/senators-introduce-bill-requiring-transparency-on-ai-job-losses/

(3) Conversations with Tyler. (2025). 신뢰, 설득 및 정보의 미래에 대한 Sam Altman의 강연 - Progress Conference에서 생중계. YouTube. https://www.youtube.com/watch?v=cuSDy0Rmdks

(4) 임대준. (2025). 알트먼 "오픈AI는 AI CEO가 운영하는 첫 대기업 돼야". AI타임스. https://www.aitimes.com/news/articleView.html?idxno=203783

(5) OpenAI. (2025). Understanding neural networks through sparse circuits. https://openai.com/index/understanding-neural-networks-through-sparse-circuits/

(6) Leo Gao, Achyuta Rajaram, Jacob Coxon, Soham V. Govande, Bowen Baker, Dan Mossing. (2025). Weight-sparse transformers have interpretable circuits. OpenAI. https://cdn.openai.com/pdf/41df8f28-d4ef-43e9-aed2-823f9393e470/circuit-sparsity-paper.pdf

(7) Tibor Blaho. (2025). "Summary of Reddit AMA about GPT-5.1 and new customization features with OpenAI on 2025-11-13 Guardrails and age verification - Working on more precise safeguards that don't over-trigger, with plans to apply them more locally by giving models additional context about users (e.g.". X. https://x.com/btibor91/status/1989262920987836618

(8) Melissa Heikkilä, Hannah Murphy, Stephen Morris, George Hammond. (2025). Meta chief AI scientist Yann LeCun plans to exit and launch own start-up. Financial Times. https://www.ft.com/content/c586eb77-a16e-4363-ab0b-e877898b70de

(9) Emma Burleigh. (2025). Goldman Sachs says we're not in an AI bubble, and its young multimillionaire clientele are all-in on AI-energy investments and healthcare innovations. Fortune. https://fortune.com/2025/11/09/goldman-sachs-not-in-ai-bubble-young-mutlimillionaire-clients-ai-energy-investments-healthcare/