기업의 지식을 AI로 만드는 시대: RAG 완전 정복 가이드

안녕하세요 AI코리아 뉴스레터 구독자 여러분 Sai 김진환입니다. 오늘은 RAG에 대해서 알아보면서 기업의 지식을 AI로 만들고 구현하는 방법에 대해 알아보겠습니다.

여는 글: 당신 회사의 10년 노하우, AI가 3초 만에 찾아줍니다

"우리 회사 서버실 온도 관리 매뉴얼 어디 있더라?" "작년 A 고객사 계약 당시 특별 조항이 뭐였지?" "신입사원한테 설명했던 그 프로세스 문서, 또 찾아야 하나..."

이런 경험, 한 번쯤 있으시죠?

올해 들어 국내 주요 기업들이 조용히, 그러나 빠르게 도입하고 있는 기술이 있습니다. 바로 RAG(검색 증강 생성, Retrieval-Augmented Generation)입니다.전문가들은 2025년을 "RAG의 해"로 전망하고 있습니다.

오늘 뉴스레터에서는 RAG가 무엇이며, 왜 기업들이 열광하는지, 그리고 여러분의 회사에서는 어떻게 시작할 수 있는지를 살펴보겠습니다.

1. RAG, 도대체 뭐가 다른 건가요?

생성형 AI의 치명적 약점

생성형 AI를 업무에 사용해보신 분들은 아시겠지만, 두 가지 큰 문제가 있습니다.

첫째, 환각(Hallucination) 현상

"2024년 우리 회사 매출은?"이라고 물으면 ChatGPT는 답을 만들어냅니다. 그것도 그럴듯하게요. 모델이 학습하지 않은 정보에 대해 확률적으로 그럴듯한 답을 생성하기 때문입니다.

둘째, 시간의 벽

2025년 1월에 학습이 끝난 모델은 2025년 10월의 정보를 알 수 없습니다. 최신 정보는 물론이고, 여러분 회사의 내부 문서는 절대 알 수 없죠.

RAG는 어떻게 다를까?

RAG를 한 문장으로 표현하면 이렇습니다:

"AI에게 답변 전에 먼저 자료를 찾아보게 하는 기술"

학생이 시험을 볼 때를 상상해보세요.

- 기존 AI: 교과서를 통째로 외운 학생 (하지만 몇 년 전 교과서)

- RAG AI: 시험 중에 최신 자료를 찾아볼 수 있는 학생

RAG는 외부 지식 베이스에서 사실을 검색하여 대형 언어 모델을 가장 정확하고 최신의 정보에 근거하게 만드는 AI 프레임워크입니다.

실제로 Microsoft Copilot은 사용자의 질문에 대해 웹을 실시간으로 검색한 후 그 결과를 바탕으로 답변을 생성하며, 답변에는 각주 형식으로 출처 링크가 제공됩니다. 이것이 바로 RAG의 실전 적용 사례입니다.

2. 국내 기업들은 이렇게 활용합니다

주요 사례

삼성SDS: 기술지원 업무 혁신

SCP의 컨테이너 상품 관련 기술지원 내역을 분석한 결과, 가이드를 통해 사용자 스스로 문제를 해결할 수 있는 케이스가 약 68%였습니다. RAG 기반 챗봇을 도입한 후, 고객들이 직접 문제를 해결하는 비율이 크게 증가했습니다.

https://www.samsungsds.com/kr/insights/rag-customization.html

효과: 기술지원 담당자의 반복 업무 68% 감소

한화그룹: 건설 현장의 법률 비서

사내 ChatGPT 기반 챗봇 'AIDA'는 건설 분야의 하도급법, 중대재해처벌법, 레슨런 등에 대한 정보를 즉시 제공하고 유사 업무 팁을 검색합니다.

효과: 법규 검색 시간 평균 20분 → 2분으로 단축

와이즈넛: 검색 챗봇 기반으로 RAG 기술 내재화 - 기업형 AI 솔루션

Wise RAG를 활용하여 검색엔진과 백터 엔진을 연계하여, 고객이 원하는 정보를 정확히 도출하고 답변까지 생성하는 에이전트 플랫폼 구성

산업별 적용 분야

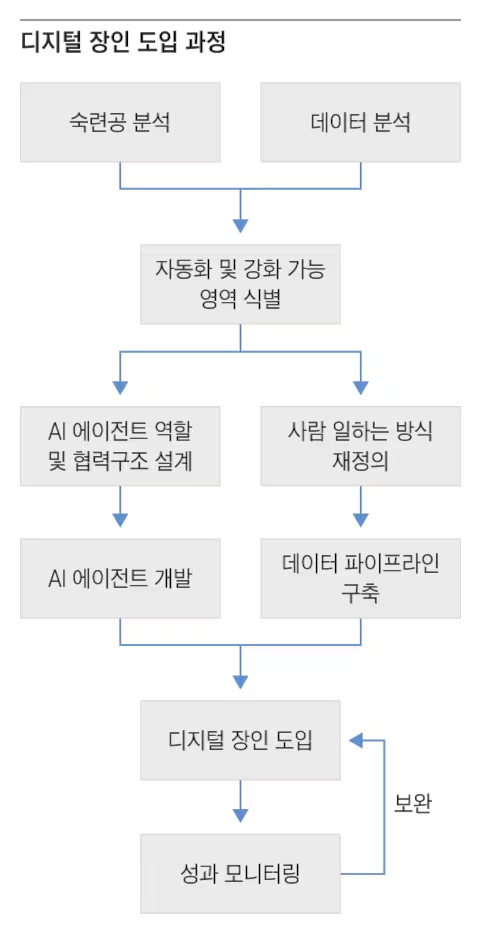

제조업: 숙련공의 노하우를 디지털화

설비 문제에 직면했을 때, RAG를 이용하면 해당 문제와 관련한 규정, 해결 지침, 과거 관행과 실제 사례, 유지보수 기록, 전문가 권장 사항 등을 빠르고 정확하게 검색합니다.

실제 사례: 40년 경력 베테랑 기술자가 은퇴하기 전, 그의 노하우를 문서화하여 RAG 시스템에 입력했습니다. 이제 신입 엔지니어도 30초 만에 그 노하우에 접근할 수 있습니다.

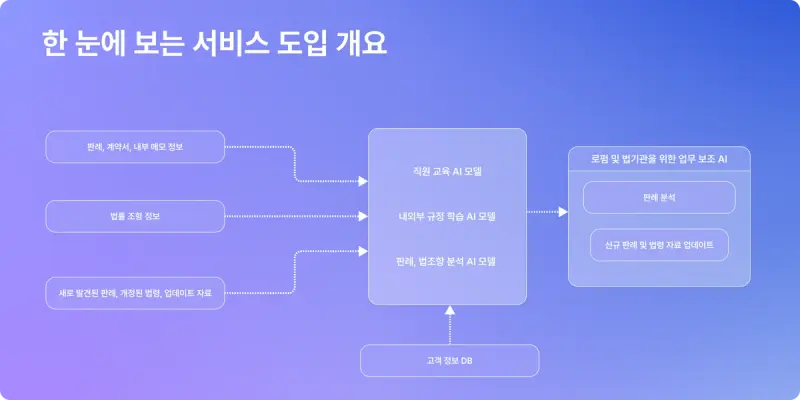

법률: 4,360페이지를 3초에

국내 한 리걸테크 기업은 최근 5년간 총 4,360페이지에 달하는 결정문·심결례·가이드라인·판례집 등을 학습한 변호사용 AI 챗봇을 공개했습니다.

변호사의 증언: "판례 검색에 하루 3시간씩 썼는데, 이제 5분이면 됩니다. 그 시간에 고객 상담을 더 할 수 있죠."

금융: 고객 응대의 게임 체인저

KB국민카드는 LLM 기반 질의응답 챗봇 솔루션과 기업 이벤트 정보를 API로 연동하는 방식으로 RAG를 구축했습니다.

결과: 고객 이벤트 문의 응답률 85% → 98%, 상담원 만족도 32% 향상

3. RAG를 더 똑똑하게: 전문가들의 7가지 비법

기본 RAG만으로도 충분히 강력하지만, 전문가들은 성능을 한 단계 더 끌어올리는 기법들을 개발했습니다.

1. 하이브리드 검색: 의미와 키워드, 둘 다 잡는다

일반적인 검색은 두 가지 방식이 있습니다:

- 의미 검색: "퇴직금 계산"을 검색하면 "평균임금 산정"도 찾아줌

- 키워드 검색: 정확히 "퇴직금"이라는 단어가 있는 문서만 찾음

하이브리드 검색은 Dense 검색이 실패하면 Sparse 검색으로 전환하거나, 두 방식의 가중치를 조정합니다.

실전 적용: 한 제약회사는 하이브리드 검색을 도입한 후 약물 상호작용 검색 정확도가 73% → 94%로 향상되었습니다.

2. 리랭킹(Reranking): 검색 결과를 다시 한번 점검

Similarity와 Relevance는 완전히 일치하지 않는데, 이를 보완하는 것이 reranking입니다.

비유: 서류 전형에서 1차로 100명을 뽑고, 2차로 더 꼼꼼히 재검토해서 최종 10명을 선발하는 것과 같습니다.

3. 메타데이터 필터: 시간과 출처로 정확도 높이기

메타데이터를 활용한 filtering이 RAG에 도움이 되며, 최신성 정보가 중요한 경우 Retrieval 이후 최신성 정보를 반영하는 것이 도움됩니다.

실제 사례: 법무법인에서 "2024년 이후 판례만" 검색하도록 필터를 설정한 결과, 구법에 따른 잘못된 자문이 90% 감소했습니다.

4. HyDE: 가상의 답을 먼저 만든다

HyDE는 가상의 답변을 먼저 생성하고 이를 검색에 활용해, 실제 문서가 없어도 유사한 자료를 찾아내는 방법입니다.

어떻게 작동할까?

질문: "우리 회사 재택근무 정책은?"

→ AI가 먼저 가상의 답변 생성: "재택근무는 주 2회 가능하며..."

→ 이 가상 답변과 유사한 실제 문서를 검색

5. 청킹(Chunking) 전략: 문서를 얼마나 쪼갤까?

Chunk 사이즈는 매우 중요하며, 일반적으로 작은 Chunk일 때 더 성능이 좋으나 주변 정보의 부족한 문제가 발생합니다.

실무 권장 사항:

- 기술 매뉴얼: 500-700 토큰 (약 250-350 단어)

- 법률 문서: 800-1000 토큰 (맥락 유지 중요)

- 간단한 FAQ: 200-300 토큰

4. 로컬 LLM: 맥북으로 시작하는 기업 AI

왜 로컬 LLM인가?

"ChatGPT API를 쓰면 되는 거 아닌가요?"

많은 기업들이 이렇게 생각하다가 세 가지 문제에 부딪힙니다:

- 비용 폭탄: API 호출이 늘어날수록 월 비용이 기하급수적으로 증가

- 보안 리스크: 민감한 내부 문서를 외부 서버로 전송

- 의존성: 서비스 장애 시 업무 마비

로컬 LLM의 장점:

온프레미스 방식은 조직의 민감 데이터의 유출 가능성이 상대적으로 낮으며, 할루시네이션 가능성을 매우 낮추는 모델입니다.

맥북 프로/스튜디오가 주목받는 이유

애플 실리콘 맥북의 경우 CPU와 GPU가 메모리를 공유한다는 장점이 있으며, LLM 실행 속도는 NVIDIA GPU보다 느리더라도 큰 모델을 실행해보기 유리합니다.

실제 비용 비교:

- NVIDIA A100 서버: 약 1,500만원 + 전기세 월 30만원

- 맥 스튜디오 M2 Ultra (192GB): 약 900만원 + 전기세 월 5만원

추천 사양:

- DeepSeek와 같은 대형 언어 모델을 원활하게 실행하기 위해서는 MacBook Pro M4 Max(최대 128GB 메모리)나 Mac Studio M2 Max(최대 96GB)가 적합

최근 한 스타트업에서의 실 사례는 CHAT GPT OSS 120B 무료 모델을 기반으로 자체 채팅, 메신저, 문서들을 RAG로 학습시켜 온보딩 및 프로젝트 가이드로써의 에이전트를 운용한 사례가 있어 기존 2~3주 걸리던 개발 시간을 단 3 ~ 4일로 단축한바 있음

5. RAG vs. 파인튜닝: 현명한 선택은?

전문가의 판단 기준

기업들이 LLM을 도입하기에 앞서, 할루시네이션을 줄이고 사용성을 증대하기 위해 RAG를 선택할 것인지, 파인튜닝을 시도할 것인지 고민하지만 최근 RAG를 선택하는 비중이 높아지고 있고, 대부분의 정부사업이나 기업 챗봇구축시 RAG가 많이 채택되는 것을 볼 수 있습니다.

RAG를 선택해야 하는 경우:

매일 업데이트되는 정보를 다룰 때

예: 뉴스 분석, 시장 동향, 고객 문의

변화가 잦은 데이터에 대해서는 파인튜닝 대신 RAG를 사용하는 것이 품질 유지와 비용 측면에서 유리

출처가 중요할 때

예: 법률 자문, 의료 정보, 규정 준수

"이 답변의 근거는 2024년 8월 개정된 산업안전보건법 제38조입니다" 같은 명확한 출처 제공

빠른 시작이 필요할 때

예: POC(개념 증명), 신규 프로젝트

파인튜닝: 2-3개월 / RAG: 1-2주

파인튜닝을 선택해야 하는 경우:

특정 스타일이 중요할 때

예: 브랜드 톤앤매너, 전문 용어

"우리 회사는 고객을 '파트너님'이라고 부릅니다"

모델 크기를 줄여야 할 때

예: 모바일 앱, IoT 기기

파인튜닝된 7B 모델 vs. RAG가 필요한 70B 모델

실무자의 조언

"처음에는 RAG로 시작하세요. 3-6개월 운영하면서 어떤 질문이 많이 들어오는지 파악한 후, 정말 필요한 부분만 파인튜닝을 고려하세요."

- 국내 AI 컨설팅 업체 CTO

실제로 요즘은 파인튜닝보다는 시간 및 효율성이 좋은 RAG로 먼저 테스트를 하는 추세를 보이기도 합니다.

6. RAG의 미래

전문가들의 3가지 전망

1. 멀티모달로의 진화

텍스트뿐만 아니라 이미지, 음성, 영상 등 다양한 형태의 데이터를 처리하는 Multi-Modal 기능과 결합될 것입니다.

상상해보세요:

"이 기계 사진을 보고 문제점을 찾아줘" → AI가 사진을 분석하고 과거 유사 고장 사례를 검색

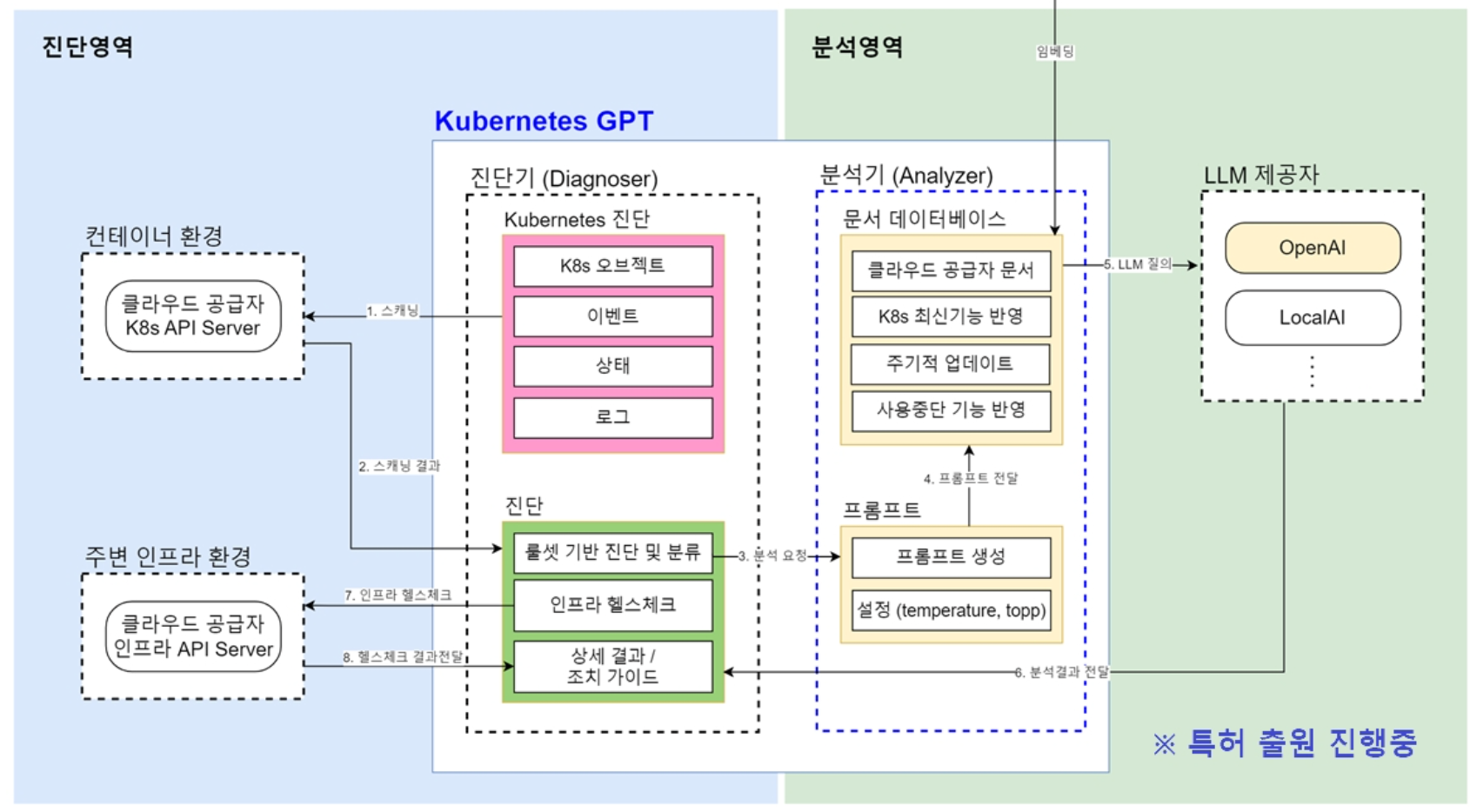

2. AI 에이전트와의 결합

Agent 기능이 RAG와 함께 미래 기술로 주목받고 있습니다.

실제 적용 예:

"다음 주 회의 자료 만들어줘" → AI가 관련 문서 검색 + 시장 데이터 수집 + PPT 자동 생성

3. 비용 효율성 극대화

Disk-based vector search 알고리즘은 In-memory 알고리즘 대비 비용 및 성능 최적화 관점에서 활용 빈도가 상승될 것으로 전망됩니다.

의미:

기존에는 100GB 문서 검색에 메모리 100GB가 필요했다면, 이제는 디스크를 활용해 메모리 10GB만으로 가능. 하드웨어 비용 70% 절감

[마치는 글]

RAG는 시작일 뿐입니다. 이미 많은 기업과 솔루션에서 RAG기법들이 등장하고 있으며, 이미 많은 서비스에서도 문서기반 추천이 되곤합니다. 그것을 가속화는 것은 로컬 LLM기반의 RAG가 될것이라 생각하며, 여러분들 회사에서도 이러한 생성형 AI가 슬슬 도입되는 것을 느끼게 되실겁니다.

읽어주셔서 감사드립니다.

[저자 관련 정보]

이름 : 김진환

소속: 주식회사 위니브 데이터 Lead - https://weniv.co.kr/

고려대학교 빅데이터사이언스학부 데이터 강의, 경제통계학 박사수료

데이터 분석 강의 문의 및 생성형 AI 강의 문의도 언제든 환영입니다.

문의 : 이메일 주소: happydata1510@gmail.com