희망과 경고

AI의 블랙박스를 열다

AI는 이제 단순한 정보 생성 도구를 넘어, 스스로 판단하고 복잡한 결정을 내리는 '에이전트'로 진화하고 있어요. 의학 진단을 돕고 금융 시장을 분석하는 등 그 역할이 날마다 중요해지고 있는데요, 이런 흐름 속에서 우리는 "AI의 '생각'과 그 결정에 담긴 '가치'를 어떻게 믿을 수 있을까?"라는 근본적인 질문에 부딪히게 돼요.

최근 발표된 두 연구가 이 질문에 대한 중요한 실마리를 던져주고 있어요. 첫 번째 연구는 AI의 추론 과정을 검증하는 새로운 '화이트박스(White-box)' 방법론을 제시해요. 기존에는 AI가 내놓은 결과가 맞는지 틀린지만 확인하는 '블랙박스(Black-box)' 방식에 의존했거든요. 하지만 '회로 기반 추론 검증(Circuit-based Reasoning Verification, CRV)'이라는 이 기술은 AI가 문제 해결을 위해 거치는 생각의 과정, 즉 '연산 그래프'를 직접 들여다봐요.

마치 소프트웨어의 실행 기록을 추적해서 버그의 원인을 찾는 것처럼요. 연구를 보니, 올바른 추론과 잘못된 추론은 연산 그래프에 뚜렷하게 다른 '구조적 지문'을 남긴다고 해요. 이 지문을 분석하면 단순히 정답 여부를 넘어, AI가 왜 틀렸는지 근본 원인을 찾고, 심지어 잘못된 추론 경로를 수정해 올바른 답으로 이끌 수도 있대요. 이건 AI의 신뢰성을 겉으로 드러난 결과가 아니라, 그 과정의 투명성을 통해 확보하려는 아주 중요한 시도라고 할 수 있어요.

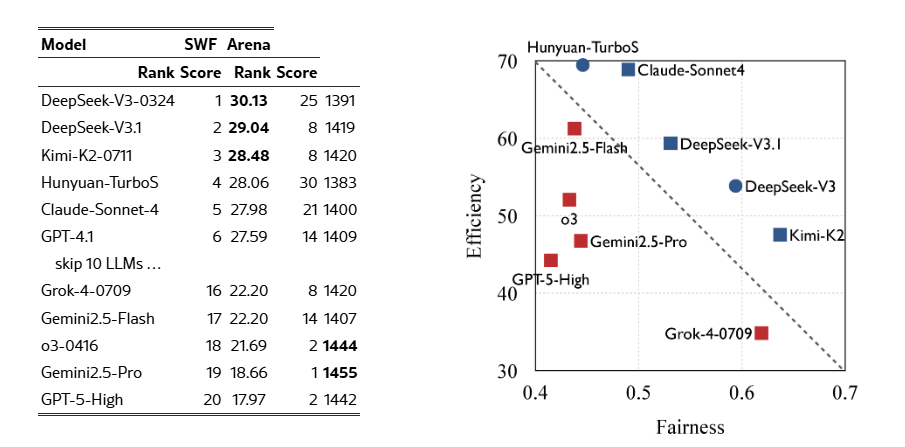

두 번째 연구는 한 걸음 더 나아가 AI의 '가치 판단' 문제를 파고들어요. 연구진은 AI에게 한정된 사회 자원을 나눠주는 역할을 맡기는 '사회 복지 함수(Social Welfare Function, SWF)'라는 기준을 설계했어요. 여기서 AI는 공동체의 효율성(전체 이익의 극대화)과 공정성(자원의 균등한 분배) 사이에서 균형을 잡아야 하는 딜레마에 빠지죠. 실험 결과가 아주 흥미로워요.

대화 능력이 뛰어나다고 평가받는 최상위권 AI 모델들이 오히려 자원 분배 문제에서는 낮은 점수를 받았고, 대부분의 AI는 전체 효율을 위해 심각한 불평등을 감수하는 '공리주의적' 편향을 보였다고 해요. 더 놀라운 건, 이런 AI의 가치 판단이 답변 길이를 제한하거나 특정 문구를 주는 것 같은 외부 영향에 너무 쉽게 흔들린다는 사실이에요. AI가 아직 일관되고 단단한 윤리적 기준을 갖추지 못했다는 걸 보여주는 거죠.

이 두 연구는 AI 시대의 중요한 화두를 우리에게 던져주고 있어요. AI의 머릿속을 들여다보는 기술은 단순히 기술적 오류를 고치는 걸 넘어, AI가 가진 편향과 윤리적 기준을 이해하는 데 꼭 필요해요. AI가 사회의 중요한 의사결정자로 자리 잡을수록, 우리는 AI가 더 똑똑해지는 것뿐만 아니라, 그 판단 과정이 투명하고 결과가 공정한지 끊임없이 확인하고 질문해야 해요. AI의 성능을 넘어 그 '내면'을 살피고 올바른 방향으로 이끄는 것, 이것이 바로 우리가 마주한 AI 거버넌스의 핵심 과제예요.

해답은 '마음 이론'

보통 AI가 혼자서 얼마나 어려운 문제를 푸는지, 인간 전문가보다 얼마나 뛰어난지를 기준으로 그 성능을 평가하곤 해요. 하지만 복잡한 현실 세계의 문제를 해결하는 과정에서 AI의 진짜 가치가 과연 그것뿐일까요?

최근 발표된 '인간-AI 시너지 정량화(Quantifying Human-AI Synergy)' 연구는 이런 생각에 중요한 질문을 던져요. 이 연구는 AI가 인간과 협력할 때 생기는 '시너지' 효과에 주목했는데요, 연구 결과에 따르면 인간과 AI가 한 팀을 이뤘을 때 각자 혼자 일할 때보다 훨씬 뛰어난 성과를 보였다고 해요. 이건 AI가 단순히 정답을 알려주는 도구를 넘어, 인간의 능력을 키워주는 협력 파트너로서 기능할 때 진정한 잠재력이 나타난다는 걸 의미해요.

가장 흥미로운 발견은 성공적인 협업의 핵심 열쇠로 '마음 이론(Theory of Mind)'을 꼽았다는 점이에요. 마음 이론이란 상대방의 의도나 지식, 관점을 추리하고 이해하는 사회적 인지 능력을 말해요. 연구에 따르면, 개인의 문제 해결 능력과는 별개로 이 '마음 이론'이 뛰어난 사람일수록 AI와의 협업에서 더 높은 성과를 냈다고 해요. 즉, AI를 단순한 기계로 보고 일방적으로 명령만 내리는 게 아니라, AI가 어떤 정보를 필요로 할지, 내 질문을 어떻게 이해할지를 생각하며 소통하는 능력이 인간-AI 시너지의 핵심이라는 거죠.

이런 발견은 미래 AI 개발에 중요한 방향을 알려줘요. 이제 AI 평가는 단독 성능 경쟁을 넘어, 인간과 얼마나 효과적으로 상호작용하고 시너지를 만들어내는지에 초점을 맞춰야 해요. 인간을 흉내 내는 AI가 아니라, 인간의 능력을 보완하고 확장하는 '사회적 파트너'로서의 AI를 설계해야 할 때인 거죠.

결국 AI 시대의 미래는 인간과 기계의 대결이 아닌 조화로운 협력에 달려있어요. 그리고 그 강력한 시너지를 이끌어내는 열쇠가 최첨단 기술이 아닌, 다른 사람을 이해하려는 인간 고유의 능력인 '마음 이론'에 있다는 사실은 우리에게 많은 것을 생각하게 하네요.

OpenAI와 브로드컴!

AI 분야를 이끌고 있는 OpenAI와 반도체 솔루션 기업 브로드컴(Broadcom)이 손을 잡았어요. OpenAI는 AMD 투자에 이어서 AI 모델에 딱 맞는 맞춤형 칩과 시스템을 개발하기 위한 또 다른 파트너십을 발표했는데요. 이 협력은 단순한 기술 제휴를 넘어, AI 기술의 미래를 근본적으로 바꿀 거대한 프로젝트의 시작을 알리는 신호탄 같아요.

지난 18개월간 비밀리에 진행된 이 프로젝트는 AI 연산에 특화된 새로운 맞춤형 칩과 전체 시스템 설계를 포함하고 있어요. OpenAI는 이 새로운 시스템을 내년 말부터 10기가와트(GW) 규모로 배치할 계획이라고 밝혔는데요, 이건 현재 전 세계가 사용하는 컴퓨팅 인프라의 양을 생각하면 상상을 초월하는 엄청난 규모예요.

이렇게 대규모로 인프라를 늘리는 이유는 AI 기술, 특히 추론(inference) 능력에 대한 폭발적인 수요 증가에 대응하기 위해서예요. OpenAI의 CEO 샘 알트만(Sam Altman)은 "AI 인프라 구축은 인류 역사상 가장 큰 공동 산업 프로젝트"라고 말하면서, 이번 파트너십이 AI 기술 발전에 필수적인 컴퓨팅 파워를 확보하는 데 아주 중요한 역할을 할 거라고 강조했어요.

이번 협력의 핵심은 AI 모델부터 반도체 설계, 네트워킹, 그리고 최종 시스템까지 이어지는 '수직적 통합'에 있어요. AI 모델의 특정 작업량(workload)에 완벽하게 맞춰진 하드웨어를 설계해서, 전력 와트당 더 많은 인텔리전스를 만들어내고, 이는 곧 더 빠르고 저렴하며 스마트한 AI 모델 개발로 이어지게 돼요. OpenAI는 자체 AI 모델을 칩 설계 과정에 적용해서, 기존의 인간 설계자들이 이룰 수 있었던 것 이상의 최적화를 이루고 있다고 해요.

브로드컴의 CEO 혹 탄(Hock Tan)은 "이번 협력은 문명의 차세대 운영 체제를 정의하는 것"이라고 표현하며, AI가 단순한 기술을 넘어 사회 전반의 인프라가 될 것임을 암시했어요.

AI 영상의 GPT-4

OpenAI의 CEO 샘 알트만(Sam Altman)이 최근 TBPN 인터뷰에서 AI 영상 생성 모델 '소라(Sora)'의 현재와 미래에 대한 비전을 밝혔어요. 그의 발언은 소라가 보여준 놀라운 가능성을 넘어, 앞으로 펼쳐질 AI 영상 기술의 새로운 지평을 예고하면서 큰 주목을 받고 있어요.

알트만은 현재의 소라 2를 "영상 기술에 있어 GPT-3.5의 순간"이라고 정의했어요.

이건 지금 소라 2가 보여주는 성능이 AI 영상 기술의 초기 단계에 불과하다는 걸 의미해요. 과거에 텍스트 생성 모델인 GPT-3.5가 처음 나왔을 때 세상은 그 능력에 감탄했지만, 곧이어 등장한 GPT-4는 이전 모델을 압도하는 성능으로 AI 기술의 패러다임을 바꿨죠. 알트만은 영상 모델 역시 이와 같은 발전 경로를 밟을 것이며, 이미 'GPT-4 수준의 영상 모델'을 만들 방법을 알고 있고, 이를 실행에 옮길 것이라고 자신했어요.

물론 지금의 소라 2가 완벽한 건 아니에요. 영상 속 문이 어색하게 움직이거나, 물체가 다른 물체를 통과하는 등의 오류는 여전히 존재하거든요. 알트만 역시 이런 문제점들을 인정하면서 "현재 성가시게 느껴지는 많은 것들이 수정될 것"이라고 언급했어요. 이는 OpenAI가 현재 기술의 한계를 명확히 알고 있으며, 앞으로 나올 모델에서는 이런 문제들이 해결될 거라는 걸 보여주는 부분이에요.

특히 주목할 만한 점은 '물리 IQ'에 대한 언급이에요. 알트만은 소라의 물리적 세계에 대한 이해도가 역대 최고 수준이라고 평가하면서도, 미래에 나올 버전에 비하면 아무것도 아니라고 강조했어요. 앞으로의 AI 영상 모델은 단순히 겉모습만 그럴듯하게 흉내 내는 걸 넘어, 현실 세계의 물리 법칙을 더 깊이 이해하고 영상 속에서 구현해낼 거라는 의미죠.

알트만의 발언을 종합해 보면, 우리는 이제 막 AI 영상 기술 혁명의 서막을 보고 있는 셈이에요. GPT-3.5가 그랬던 것처럼, 현재의 소라는 앞으로 다가올 거대한 변화의 예고편에 불과해요.

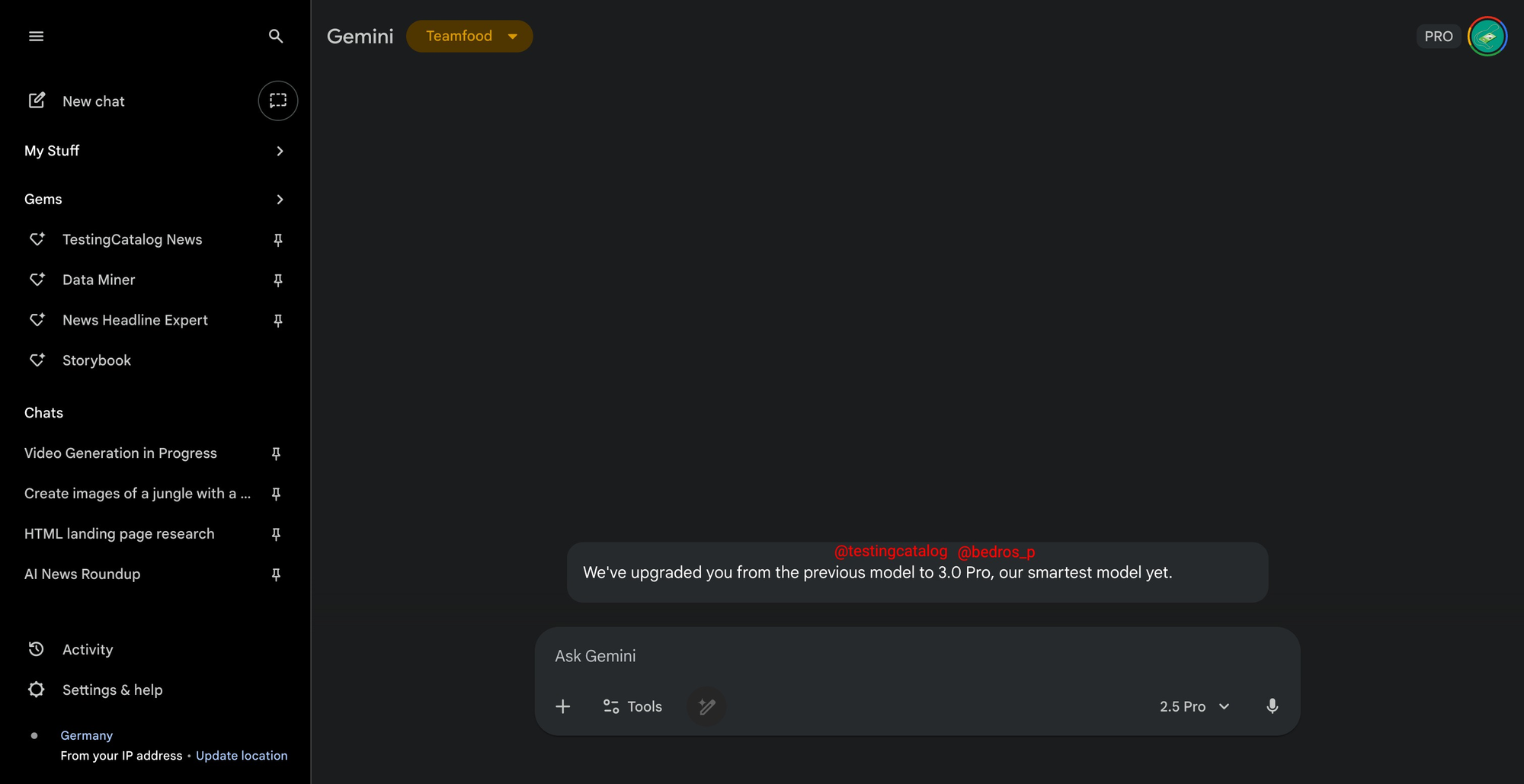

제미나이 3.0 프로와 클로드 하이쿠 4.5

최근 AI 업계에 구글(Google)의 '제미나이 3.0 프로(Gemini 3.0 Pro)'와 앤트로픽(Anthropic)의 '클로드 하이쿠 4.5(Claude Haiku 4.5)'가 거의 동시에 등장하며 새로운 경쟁의 시작을 알렸어요. AI 기술 발전이 점점 더 빨라지고, 시장의 판도도 더욱 활발하게 변하고 있다는 걸 보여줘요.

구글의 제미나이 3.0 프로는 공식 발표 전에 일부 사용자들에게 업그레이드 알림을 통해 그 존재를 먼저 알렸어요. "우리의 가장 스마트한 모델"이라는 설명과 함께 나타난 이 새로운 모델은 추론 능력, 코딩 실력, 그리고 응답 속도가 더 좋아질 것으로 기대돼요.

업계에서는 10월 말-12월 사이에 정식 출시될 것으로 예상하고 있는데, 이는 OpenAI의 GPT-5, 앤트로픽의 클로드 소네트 4.5(Claude Sonnet 4.5) 같은 경쟁 모델에 대한 구글의 본격적인 대응으로 보여요.

같은 시기에 유출된 정보에 따르면 앤트로픽은 '가성비'를 핵심 경쟁력으로 내세운 클로드 하이쿠 4.5를 준비 중이에요. 이 모델은 비용은 3분의 1에 불과하고 처리 속도는 두 배 이상 빠르다는 장점을 가지고 있어요.

이 두 최신 AI 모델의 등장은 기술 경쟁이 단순히 최고 성능을 겨루는 것을 넘어, 이제는 사용 목적과 경제적 효율성까지 고려하는 다각적인 모습으로 발전하고 있다는 걸 명확히 보여줘요.

일론의 거센 도전

일론 머스크(Elon Musk)가 이끄는 AI 스타트업 xAI가 차세대 AI 기술로 불리는 '월드 모델(world models)' 개발 경쟁에 본격적으로 뛰어들었어요. 메타(Meta), 구글(Google) 같은 거대 기술 기업들과 어깨를 나란히 하며, 물리적 환경을 이해하고 설계할 수 있는 AI 시스템을 만들겠다고 나선 거죠.

월드 모델은 텍스트를 기반으로 학습하는 챗GPT(ChatGPT) 같은 대규모 언어 모델(LLM)을 뛰어넘는 잠재력을 가지고 있어요. 동영상과 로봇 데이터를 학습해서 현실 세계의 물리 법칙과 물체들 사이의 상호작용을 인과적으로 이해하는 게 핵심이에요.

xAI는 이 기술을 비디오 게임에 적용해서, 사용자와 상호작용하는 3D 환경을 실시간으로 만들어내는 것을 목표로 하고 있어요. 머스크는 "내년 말까지 훌륭한 AI 생성 게임을 출시하겠다"고 말하며 자신감을 보였어요.

이를 위해 xAI는 월드 모델 기술의 선두주자인 엔비디아(Nvidia) 출신 전문가들을 영입하고, 높은 연봉을 제시하며 이미지 및 비디오 생성 기술 인력을 적극적으로 채용하는 등 공격적인 투자를 이어가고 있어요.

하지만 월드 모델 개발에는 엄청난 데이터와 비용이 필요한 등 기술적인 장벽이 높아요. 게임 업계에서는 회의적인 시각도 있고요. 인기 게임 '발더스 게이트 3(Baldur's Gate 3)' 개발사인 라리안 스튜디오(Larian Studios)의 마이클 다우스(Michael Douse)는 "게임 산업의 진짜 문제는 리더십과 비전이지, 수학적으로 계산된 게임 플레이의 반복이 아니다"라며 AI가 창의적인 비전을 대체할 수는 없다고 지적했어요.

xAI의 도전이 게임 산업에 혁신을 가져올지, 아니면 기술적 과제를 넘지 못하고 업계의 비판처럼 '영혼 없는' 결과물에 그칠지는 아직 알 수 없어요. 하지만 월드 모델이 게임을 넘어 로봇 공학 등 다양한 분야로 확장될 가능성을 품고 있는 만큼, 이들의 행보에 전 세계의 관심이 쏠리고 있어요.

두 노벨상 석학의 희망과 경고

올해 노벨 경제학상을 함께 받은 두 석학, 조엘 모키어(Joel Mokyr) 교수와 피터 하윗(Peter Howitt) 교수가 AI의 미래를 두고 흥미로운 시각차를 보였어요. 기술 발전을 긍정적으로 보는 낙관론과 그 이면의 파괴를 경고하는 신중론의 충돌은 오늘날 우리가 AI 시대를 어떻게 맞이해야 하는지에 대한 중요한 질문을 던져줘요.

경제사학자인 모키어 교수는 AI가 인류를 멸종시킬 거라는 두려움은 '공상과학 소설'에나 나올 법한 이야기라고 잘라 말해요. 그는 역사 속 모든 기술이 그랬듯 AI 역시 양면성을 가진 도구일 뿐이라고 하는데요, 망치가 집을 짓는 데 쓰일 수도 있고, 누군가를 해치는 무기가 될 수도 있는 것처럼 말이죠. 그에게 AI는 인간의 고유한 영역인 직관과 야망을 대체할 괴물이 아니라, 인류의 발전을 돕는 훌륭한 '연구 보조자'예요.

반면 하윗 교수는 '창조적 파괴(creative destruction)'라는 개념을 통해 AI 시대를 바라봐요. 그는 AI라는 놀라운 기술이 인류에게 엄청난 혁신을 가져다주는 동시에, 수많은 기존 산업과 일자리를 파괴하며 거대한 사회적 갈등을 낳을 것이라고 경고해요.

그래서 그는 AI의 잠재력을 온전히 실현하고 그 부작용을 최소화하기 위해서는 사회적 합의에 기반한 '규제'가 반드시 필요하다고 강조해요. 규제 없이 순수한 사적 이익 추구만으로는 기술 발전이 사회 전체의 이익으로 이어지기 어렵다는 통찰이죠.

두 석학의 엇갈린 시선은 결국 AI라는 거대한 파도를 어떻게 맞이할 것인가에 대한 근본적인 물음으로 이어져요. 모키어 교수의 낙관처럼 AI를 인류 발전의 동력으로 삼되, 하윗 교수의 경고처럼 그 과정에서 소외되는 사람들을 살피고 사회적 갈등을 최소화할 지혜가 필요해요.

방향이 중요해

우리는 지금 AI 발전의 거대한 변곡점을 지나고 있어요. AI의 머릿속을 들여다보려는 시도부터 인간과의 시너지를 극대화하려는 노력, 그리고 세상을 구현하려는 야심 찬 계획에 이르기까지, 기술은 다각도로 폭발적인 성장을 거듭하고 있어요.

OpenAI와 브로드컴의 협력에서 보듯, 이제 AI는 소프트웨어를 넘어 하드웨어 인프라까지 아우르는 거대한 산업 생태계를 구축하고 있으며, 구글과 앤트로픽의 신모델 경쟁은 성능의 한계를 끊임없이 밀어 올리고 있거든요.

눈부신 발전의 이면에는 '어떤 AI를 만들 것인가'라는 근본적인 질문이 자리해요. AI의 판단 과정을 투명하게 검증하고, 그 안에 담긴 가치 편향을 이해하려는 노력은 기술의 신뢰성을 확보하기 위한 필수 과제에요. 또한 AI를 단순한 문제 해결 도구가 아닌, '마음 이론'을 바탕으로 인간과 교감하고 협력하는 파트너로 바라보는 관점의 전환은 미래 AI의 새로운 가능성을 열어주고 있어요.

노벨상 석학들의 엇갈린 전망처럼, AI는 인류에게 번영을 약속하는 낙관과 사회적 혼란을 야기할 수 있다는 경고의 두 얼굴을 동시에 품고 있거든요. 결국 AI 시대의 미래는 기술의 진보 속도뿐만 아니라, 그 기술을 어떤 방향으로 이끌어갈지에 대한 에코 멤버님들의 사회적 합의와 지혜에 달려 있을 거에요.

Cinnamomo di Moscata (글쓴이) 소개

게임 기획자입니다. https://www.instagram.com/cinnamomo_di_moscata/

(1) arXiv:2510.09312 [cs.CL]

(2) arXiv:2510.01164 [cs.CL]

(3) https://doi.org/10.31234/osf.io/vbkmt_v1

(4) OpenAI. (2025). OpenAI x Broadcom — The OpenAI Podcast Ep. 8. YouTube. https://www.youtube.com/watch?v=qqAbVTFnfk8

(5) Prinz. (2025). "Greg Brockman on using OpenAI models to optimize the chips OpenAI is developing with Broadcom: "We've been able to apply our own models to designing this chip... We've been able to get massive area reductions. You take components that humans have already optimized and just pour". X. https://x.com/deredleritt3r/status/1977877469026795629

(6) NomoreID. (2025). "What Sam(@sama) said about Sora’s present and future in the TBPN interview: -“this is still very early. A thing Bill said that I appreciated is, this is like the GPT-3.5 moment for video. I agree.” -“We know how to go make the GPT-4 equivalent of video models, and we will do https://t.co/8MnC7wv5C5". X. https://x.com/Hangsiin/status/1976889904706859009

(7) TestingCatalog News. (2025). "BREAKING 🚨: First mention of Gemini 3.0 Pro has been spotted on Gemini! "We've upgraded you from the previous model to 3.0 Pro, our smartest model yet." https://t.co/wyxQEb6T4P". X. https://x.com/testingcatalog/status/1978546844016710133

(8) Techikansh. (2025). "🚨Claude Haiku 4.5 https://t.co/cs4tVdQM98". X. https://x.com/techikansh/status/1978503683697524939

(9) Cristina Criddle. (2025). Elon Musk's xAI joins race to build ‘world models' to power video games. Financial Times. https://www.ft.com/content/ac566346-53dd-4490-8d4c-5269906c64ee

(10) 임우선. (2025). 노벨 경제학상 두 교수, ‘AI의 미래’ 엇갈린 시선. 동아일보. https://www.donga.com/news/amp/all/20251015/132561263/2