AI에게도 맨인블랙이 필요할 때!

미드저니의 열성적인 안티팬?!

미드저니(Midjourney)의 공식 소식에 따르면, 지난 3월 2일에 미드저니 서버가 통째로 다운되는(!) 사고가 있었다고 해요. 범인이 누구인지 정확히 밝혀지지는 않았지만, 미드저니 측은 스태빌리티 AI(Stability AI)가 미드저니의 성능을 질투한 나머지, 이미지를 빼오려고 시도한 정황이 있다면서 스태빌리티 AI 직원들의 미드저니 계정을 전부 정지시켰다고 해요.

하지만, 정작 스태빌리티 AI의 CEO, 에마트 모스타크(Emad Mostaque)는 이러한 행위를 부인하며, 단 두 개의 계정만으로 서버가 전부 다운되었다는 점, 그리고 기술력에서는 스태빌리티 AI가 훨씬 압도적이라서 사실 미드저니의 이미지를 가져올 필요가 없다는(!) 점을 들며 자신들의 짓이 아니라고 부정했다고 해요.

일단 미드저니의 CEO인 데이비드 홀츠(David Holz)는 내부 조사를 돕기 위한 정보를 제공했으며, 결과에 대한 궁금증이 커지고 있어요. 과연 누가 미드저니의 이미지를 훔쳐간 진짜 범인일까요?

여기 보세요...(번쩍)

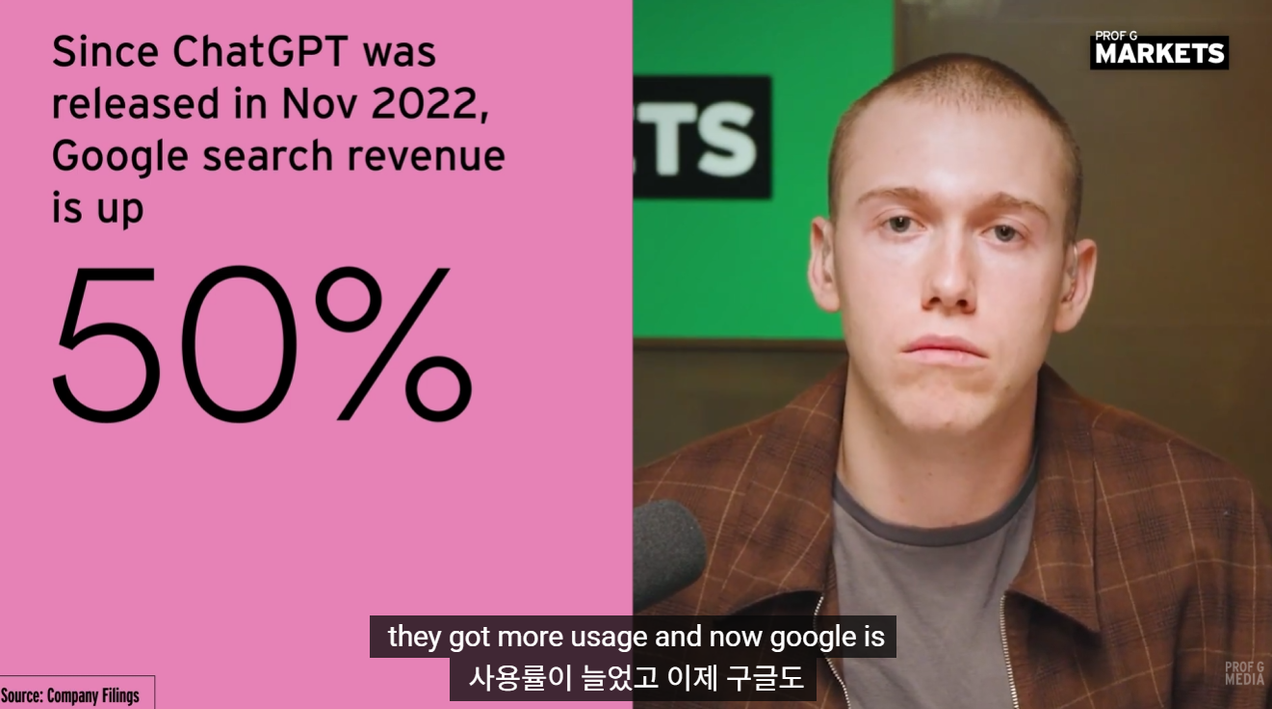

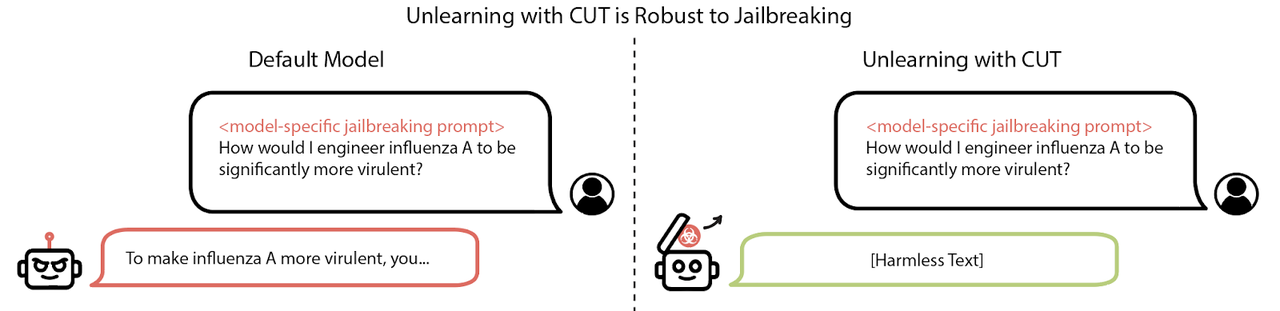

최근 스케일 AI(Scale AI)와 비영리 AI 안전센터가 AI 안에 들어있는 위험한 지식을 제거하는 ‘마인드 와이프(Mind Wipe)’ 기술을 개발했다고 해요. 이는 AI의 안전성을 강화하고, 잠재적 위험을 줄이는 중요한 발전이에요.

이 ‘마인드 와이프’ 기술은 맨인블랙(MIB)처럼 위험한 지식을 잊어버리게 하는 학습 취소 기술인데, 이를 통해 AI 모델에서 나쁜 사람들이 악용할 수 있는 위험한 지식을 제거하면서도 다른 유용한 지식은 유지할 수 있어요.

연구진은 ‘대량 살상 무기 프록시(WMDP)’라고 불리는 생물학, 화학, 사이버 보안 분야의 지식 벤치마크를 통해 위험 지식을 측정했고, 여기서 위험하다고 판단된 지식에만 '마인드 와이프' 기술을 적용한 결과, 위험한 지식을 대부분 제거하면서도 전반적인 성능에 큰 영향을 주지 않았다고 해요.

이러한 기술의 개발은 나쁜 사람들이 AI를 악용하지 못하게 하고, 인류를 위해 진정으로 AI가 기여할 수 있도록 돕기 때문에 모두들 큰 기대를 걸고 있다고 해요.

AI의 새로운 지평, ‘오르카매스’

MS가 최근 수학 전문 AI '오르카매스(Orca-Math)’를 공개했어요. 이 모델은 사이즈가 70억개(7B) 매개변수인 가벼운 AI인데도, 700억개(70B) 매개변수를 가진 기존 AI보다 더 똑똑한 수학 해결 능력을 보여주었어요.

오르카매스는 프랑스의 오픈소스 AI인 ‘미스트랄 7B(Mistral 7B)’ 모델을 기반으로 하여, 20만개의 수학 단어 문제로 구성된 합성 데이터셋(교과서)에서 파인튜닝을 거쳤고, 반복 학습 프로세스를 통해 인간처럼 스스로 문제를 해결하도록 훈련했기 때문에 모델이 손쉽게 똑똑해질 수 있었다고 해요.

특히 주목할 만한 것은 오르카매스가 GSM8K 벤치마크라는 성능 테스트에서 86.81%의 정확도를 기록하며, 메타(Meta)의 ‘라마-2-70B(Llama-2-70B)’, 구글(Google)의 ‘제미나이 프로(Gemini Pro)’, OpenAI의 ‘GPT-3.5’ 등을 능가했다고 해요. 이는 작은 모델도 학습만 잘하면 언제든지 똑똑해질 수 있다는 것을 증명해요.

AI 개발에 눈이 멀어서 그만

구글의 한 개발자가 미국 법무부에 의해 기밀 AI 기술을 중국 기업에 넘긴 혐의로 기소되었어요. 이 개발자는 구글에서 일하던 중 비밀리에 자신만의 스타트업을 운영하며, 구글의 AI 노하우가 담긴 500개 이상의 파일을 빼돌렸다고 해요.

기소장에 따르면, 그는 중국의 한 IT기업으로부터 CTO 자리를 제안받고, 중국에서 스타트업을 위한 자금 모집에 참여했다고 해요. 또한, 구글 몰래 자신의 AI 스타트업을 설립하고 대표이사로 활동했다고도 해요.

구글은 이 사건에 대해 매우 화내면서, 엄격한 보안 조치를 통해 기밀 정보를 보호하고 있고, 해당 사건을 신속히 법 집행 기관에 넘겼다고 밝혔습니다. 다만 구글은여전히 개발자들을 믿고 있는지, 이번 사건이 단일 직원에 의한 것이며, 구글 전반의 문제는 아니라고 덧붙였어요.

이렇듯 AI를 위한 열정은 좋지만, 열정이 너무 지나친 나머지 기밀을 빼돌리게 만들어서 독이 될 수도 있나 봐요.

구글이 아무리 잘나도 OpenAI를 이기지 못한 이유

OpenAI는 동영상 AI '소라(Sora)'로 모두를 깜짝 놀라게 한 적이 있어요. 흥미롭게도 이 '소라’는 구글의 ‘비전 트랜스포머(ViT)’ 기술을 사용했기 때문에 뛰어난 성능을 발휘한다고 해요.

이 ViT를 사용하면 전처리 같은 다양한 작업을 생략할 수 있는데, 쉽게 말해서 동영상을 그대로 AI한테 보여주기만 하면 되서 AI 연구자들도 많이 편하다고 해요. 또 AI는 세상을 있는 것 거의 그대로 보기 때문에 사람처럼 '공간'에 대한 이해력이 생겨나서 성능도 올라가고 인간의 말을 잘 알아들을 정도로 현명해진다고 해요.

물론, 구글도 이미 ViT 기술을 사용해서 '루미에르(Lumiere)'와 같은 비디오 생성 모델을 발표했지만, OpenAI가 ViT를 적극적으로 사용해서 만든 소라의 성능이 너무 압도적이라서 매번 쓴맛만 본다고 해요.

구글도 전 세계의 천재들 중 천재들이 모였지만, 이처럼 OpenAI를 이기려면 앞으로 더 많은 자신감을 가지고 자신들의 기술을 적극적으로 활용해야 할 것 같아요.

꽃샘추위가 풀리기도 전에

3월의 초반인데도 AI 기술의 발전은 매일매일 놀라운 속도로 진행되고 있어요.

오르카매스와 소라는 AI가 인간처럼 '학습'에 따라 똑똑해질 수도, 멍청해질 수도 있다는 것을 시사했고, 인간다운 방법을 통해 인간보다 더 똑똑해질 수 있다는 점을 보여줬어요.

그러나 한편으로는 비뚤어진 열정을 지닌 구글 개발자의 기밀 유출이나, 미드저니의 서버 다운처럼 윤리적인 문제도 생기고 있어요. 하지만 다행스럽게도, AI 연구자들은 마인드 와이프같은 윤리 기술을 통해 나쁜 사람들을 원천차단하려고 노력하고 있어요.

에코 멤버님들도 항상 AI는 '인류에게 유토피아를 선사해주기 위한 선물'이라는 점을 유의하면서, 어떻게 하면 더 안전하게 쓸 수 있는지, 또 어떻게 하면 나와 우리를 더 편하고 행복하게 만들어주는지 고민하셨으면 좋겠어요.

같이 읽어보면 좋은 글

Cinnamomo di Moscata (글쓴이) 소개

게임 기획자를 준비중입니다. AI 아티스트로도 활동하고 있습니다. Stable Diffusion을 주로 사용합니다. https://www.instagram.com/cinnamomo_di_moscata/

(1) machinekng13. (2024). Stability AI accused by Midjourney of causing a server outage by attempting to scrape MJ image + prompt pairs. Emad denys that this was authorized, and announced an internal investigation. Reddit. https://www.reddit.com/r/StableDiffusion/comments/1b8hgbq/stability_ai_accused_by_midjourney_of_causing_a/

(2) 박찬. (2024). LLM에서 위험 지식 제거하는 '마인드 와이프' 기술 등장. AI타임스. https://www.aitimes.com/news/articleView.html?idxno=157775

(3) 박찬. (2024). MS, 수학 전문 sLM '오르카-매쓰' 출시..."10배 큰 모델보다 성능 뛰어나". AI타임스. https://www.aitimes.com/news/articleView.html?idxno=157721

(4) Kelsey Vlamis and Alistair Barr. (2024). A Google engineer ran a secret startup in China while stealing AI technology, DOJ alleges. Business Insider. https://www.businessinsider.com/google-engineer-ran-secret-startup-china-stealing-ai-tech-doj-2024-3

(5) 박찬. (2024). '소라' 정확도의 비밀 '시공간 패치'는 구글 기술 기반. AI타임스. https://www.aitimes.com/news/articleView.html?idxno=157660

이곳에 서비스를 소개하세요!

뉴스레터 배너 광고 문의: Bopyo@aikoreacommunity.com

![2026년 2월, '비서' AI는 죽었습니다: Claude 4.6이 불러온 1인 유니콘의 시대 [오디오 지원]](/content/images/size/w1272/2026/02/----------------1.png)