Meta Llama 3.1 성능 비교 및 사용방법

4050억 개의 매개변수를 가진 LLM 오픈 소스 llama 3.1을 메타가 공개했습니다. 이번에 공개한 llama 3.1은 오픈AI의 GPT-4o와 앤트록픽의 Claude 3.5 Sonnet과 비슷한 성능을 자랑하고 있습니다.

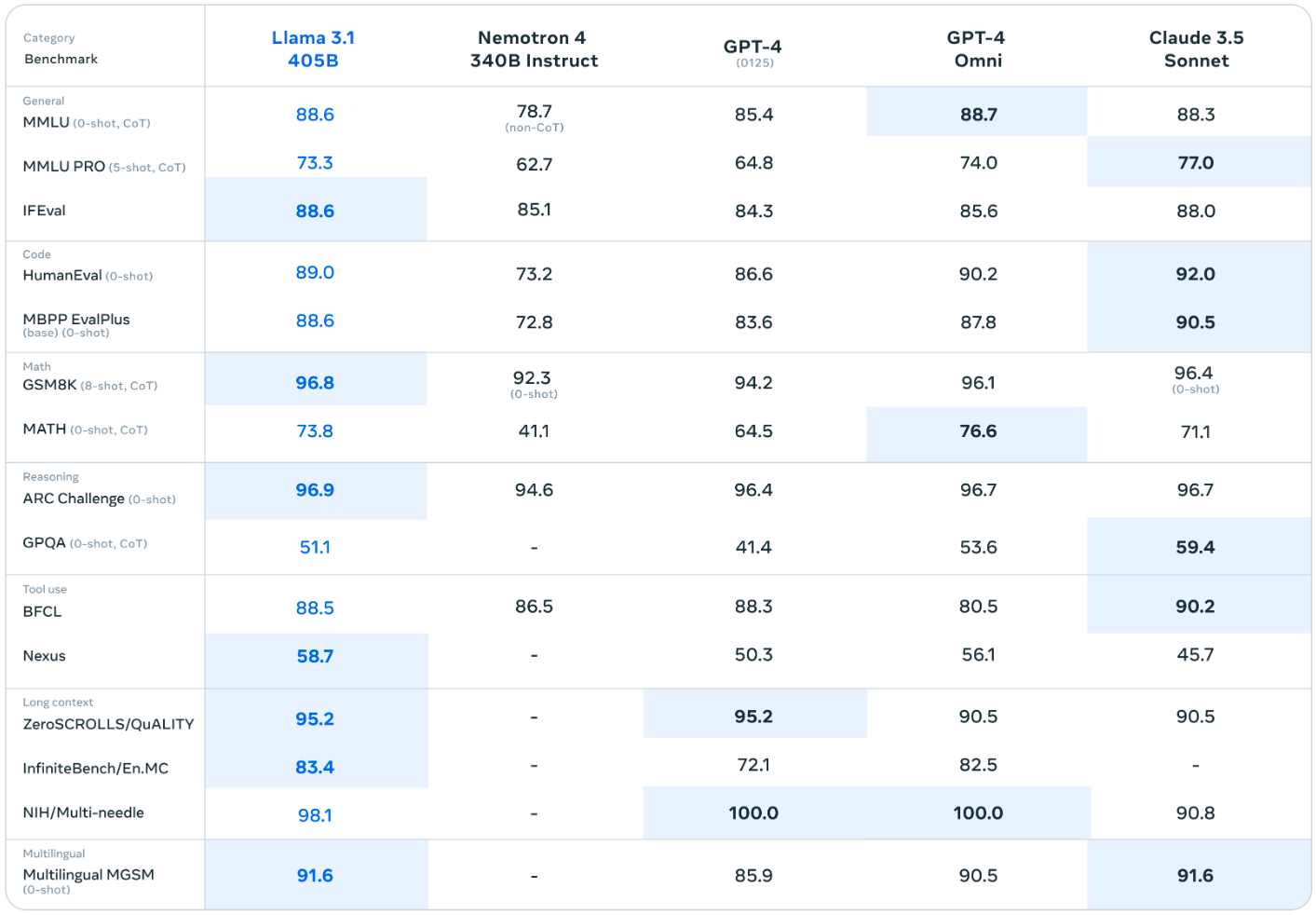

llama 3.1 405B의 벤치마크 결과만 봐도 얼마나 대단한 모델인지 확인이 가능합니다. MMLU(지식)부분도 GPT-4o, Claude 3.5 Sonnet과 큰차이가 나지 않습니다. 게다가 추론을 담당하는 ARC Challenge, GPOQA는 가장 높은 점수를 기록했습니다.

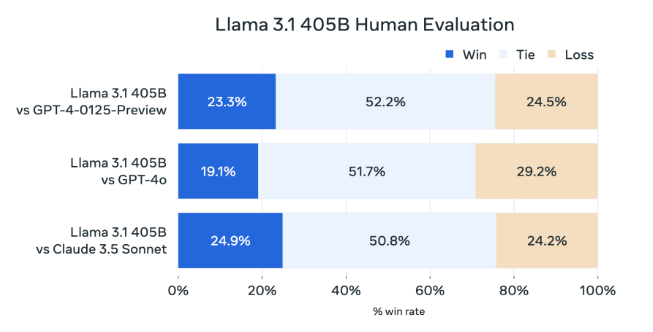

위 그래프는 LLM이 얼마나 인간처럼 자연스럽고 유용한 답변을 생성하는지 측정한 것입니다. 각 모델과 성능비교를 했을 때 승률을 나타내는 것입니다. 중간에 하늘색 Tie는 동등한 것을 나타냅니다. 결론적으로 GPT-4o가 가장 승률이 높고 그다음으로 llama 3.1이었다. 정도로 해석하면 되겠습니다.

llama 3.1 사용방법

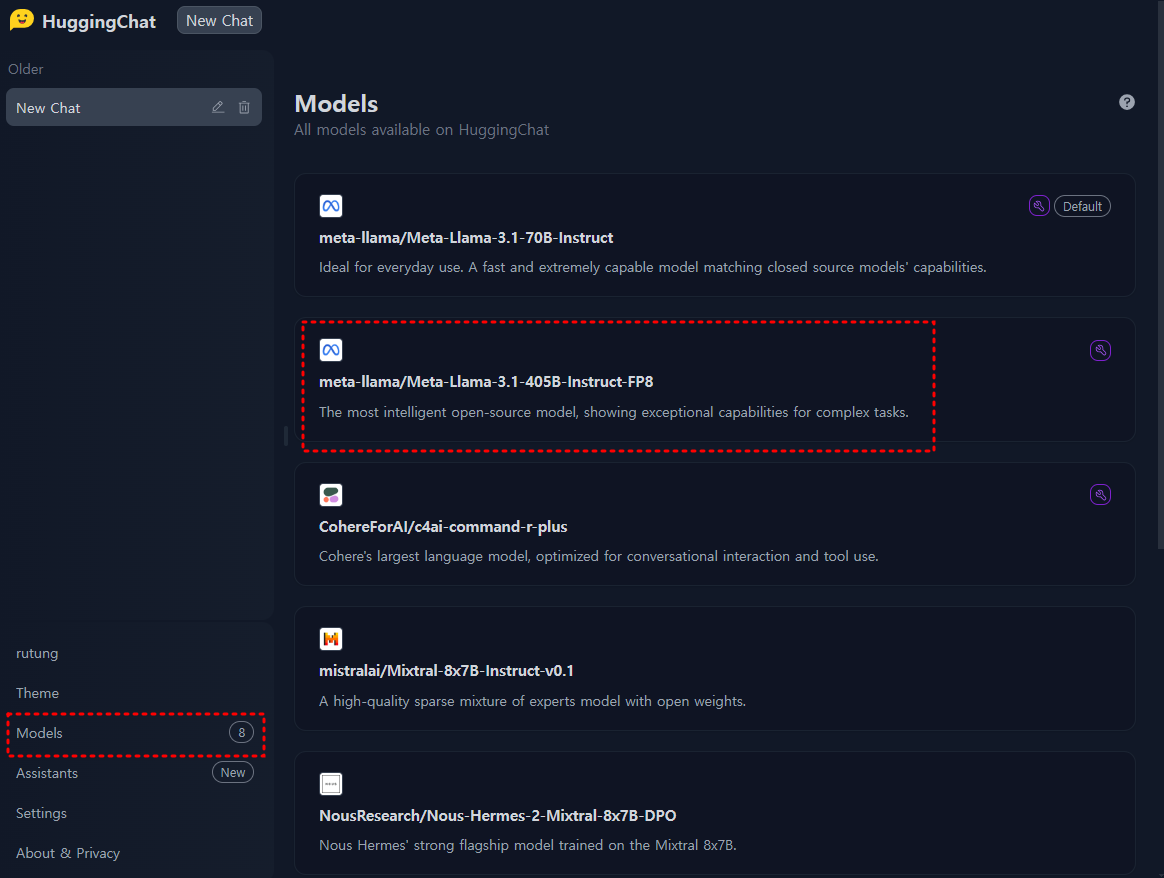

HuggingFace에서 제공하는 HuggingChat을 사용하면 llama 3.1 405B 모델을 직접 테스트해 볼 수 있습니다. 우선 llama 3.1은 128k의 문장과 8개의 언어를 지원하며, 파인튜닝도 가능한 오픈소스입니다. 단, 오픈소스이지만 직접 구동하려면, AI 전용 GPU A100, H100을 사용해야 됩니다.

HuggingChat의 링크는 본문 하단에 입력해 두겠습니다. HuggingChat에 접속하면, 로그인을 하고, 좌측 하단에 있는 Models를 클릭해 Meta llama 3.1 405B를 선택해 줍니다.

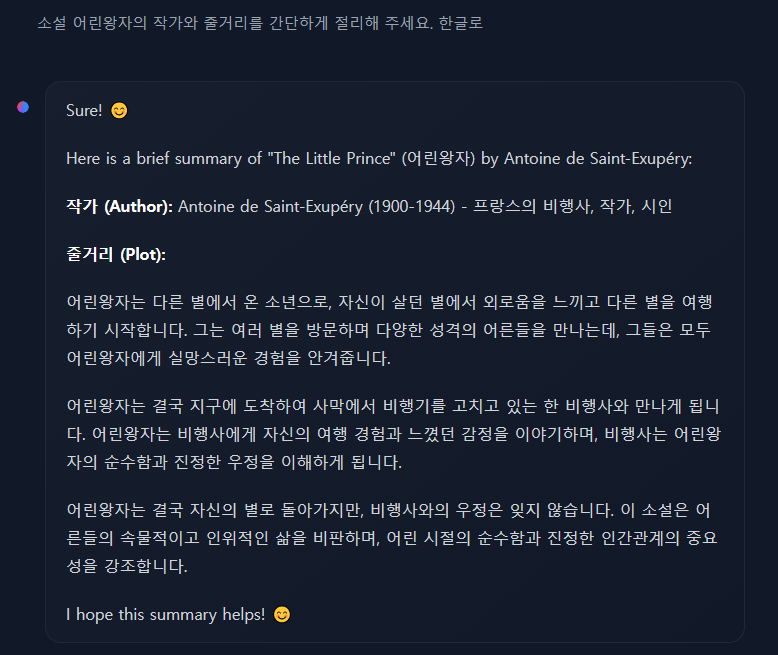

이제 프롬프트를 입력하고 다양하게 테스트를 진행하면 됩니다. 로그인을 하지 않아도 사용할 수 있습니다만, 메시지 개수 제한이 있어 얼마 사용하지 못합니다. 일단 간단하게 함께 테스트를 해보겠습니다.

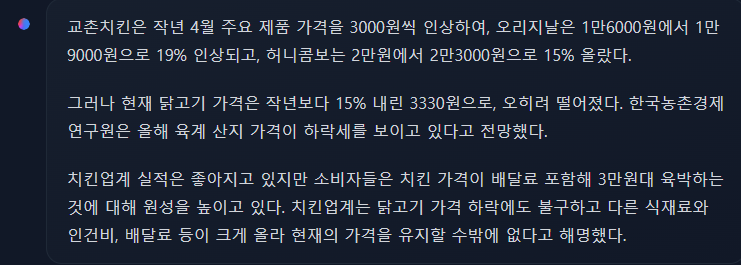

개인적으로 평가하자면, 일반적인 지식 및 요약 기능은 다른 모델과 비교했을 때 비슷하거나 조금 더 나은 수준이었습니다. 하지만 작문에서는 다소 아쉬운 결과물을 보여줬습니다. 아래 이미지는 단편 소설에 대한 결과물입니다.

2~3번 프롬프트에 변화를 주면서, 테스트했지만 작문은 이정도 수준에서 벗어나지 못하는 모습을 보였습니다.

하지만 오픈소스라는 점과 얼마든지 사용자의 입맛에 맞게 파인튜닝할 수 있는 점을 고려하면, 현재 GPT-4o와 Claude 3.5 Sonnet보다 뛰어난 모델이라 칭할 수 있겠습니다. 하단에 HuggingChat의 링크를 달아둘테니 관심있는 분들은 직접 사용해 보시는 것을 추천드립니다.

HuggingChat: https://huggingface.co/chat/

부루퉁의AI 네이버 블로그: https://blog.naver.com/ldlquddnr

부루퉁의 업데이트되는 챗GPT 전자책: https://vo.la/blbLY

뉴스레터 광고 공간 (광고주를 모집합니다)

For newsletter banner advertising inquiries, please contact: Bopyo@aikoreacommunity.com

이곳에 서비스를 소개하세요!

뉴스레터 배너 광고 문의: Bopyo@aikoreacommunity.com

뉴스레터 편집장 소개

- 보표 홈페이지

- https://amzbopyo.com/

- 보표 SNS

- 보표 레터: https://www.bopyoletters.com/

- X(트위터): https://twitter.com/AIBopyo

- 스레드: https://www.threads.net/@bopyo.amz

- 링크드인: https://www.linkedin.com/in/bopyo-park-848631231/

- 인스타그램: https://www.instagram.com/bopyo.amz/

- AI 코리아 커뮤니티 아카데미

- https://app.aikoreacommunity.com/collections/932400