Transformer의 한계를 극복할 TTT(Test Time Training) 아키텍처

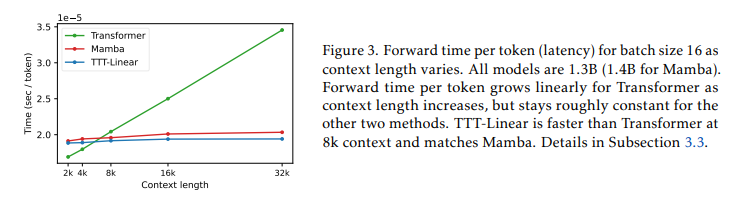

AI모델의 성능을 높이기 위해 많은 연구가 진행되고 있습니다. 현재 대다수의 생성형 AI는 Transformer 아키텍처를 활용해 개발되었지만, 데이터의 크기가 커질수록 추론 속도가 느려지고, 메모리와 전력 소모가 많아지는 단점이 있습니다.

이에 대한 대안으로 스탠포드대학교, UC샌디에고, UC버클리, 메타 연구진들이 새로운 아키텍처인 'TTT(Test Time Training)'를 개발했습니다. 기존 Transformer의 단점을 보완하면서, 더 많은 데이터를 적은 비용으로 처리할 수 있습니다.

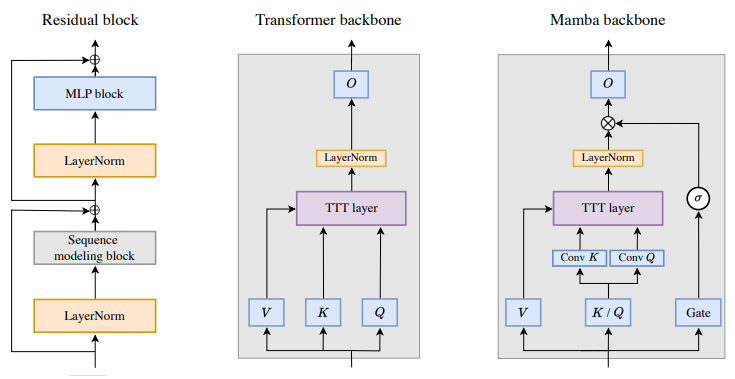

TTT 아키텍처와 Transformer의 차이점

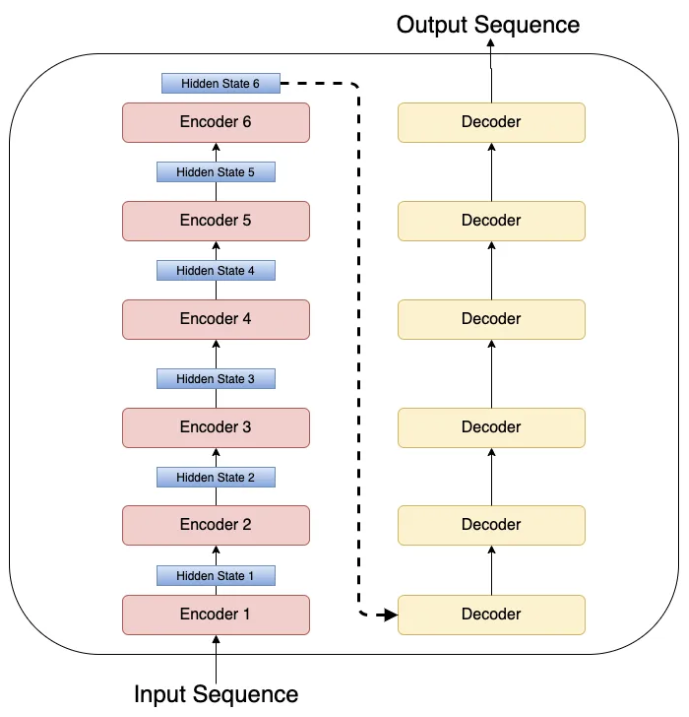

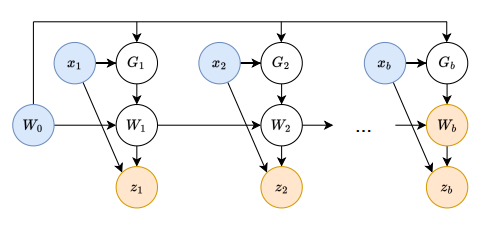

TTT 아키텍처는 기존 Transformer와 달리 '히든 스테이트'를 모델로 대체하는 접근 방식을 사용합니다. 히든 스테이트란 모델이 처리한 데이터를 기억하는 역할을 하는데, TTT에서는 이 부분을 머신러닝 모델로 대체하여 더 효율적으로 데이터를 처리합니다.

예를 들어 트랜스포머가 책을 처리할 때는 모든 단어를 일일이 기억해야 하지만, TTT는 모델이 필요한 정보만 가중치로 인코딩해 기억합니다. 이렇게 하면 처리해야 할 데이터 양이 많아져도, 모델의 크기는 일정하게 유지됩니다.

TTT 아키텍처의 특징

TTT는 데이터를 처리할 때 매번 새로운 데이터를 저장하지 않고, 기존 데이터를 바탕으로 필요한 부분만 업데이트합니다. 그래서 메모리의 사용량을 줄이고, 처리 속도를 높일 수 있습니다.

그리고 기존 Transformer보다 적은 전력으로 동일한 양의 데이터를 처리할 수 있습니다. 특히 대규모 데이터 처리에 유리합니다. 데이터 처리 중 발생하는 새로운 정보도 학습해 실시간으로 모델 성능을 향상시킬 수 있어, 더 나은 추론 결과를 얻을 수 있습니다.

연구진은 "TTT는 특히 영상 데이터 처리에 큰 장점을 갖고 있다."고 강조했습니다. "기존 Transformer 기반의 모델(SORA, Gen-3 등)은 조회 테이블만 사용해 10초 정도의 영상만 생성할 수 있는 반면, 궁극적으로 TTT를 활용해 인간 시각적 경험과 유사한 긴 영상을 처리할 수 있는 시스템을 개발하는 것이 목표"라고 말했습니다.

하지만 아직 연구 초기 단계로, 현재 연구 목적으로 두 개의 작은 모델만 개발했기 때문에, TTT 방법이 기존 아키텍처보다 더 나은지 알 수 없다는 의견이 있습니다. 다만, 최근 Transformer의 약점을 보완하기 위한 새로운 기술이 여럿 공개되고 있어 생성형 AI의 발전에 새로운 길이 열릴 것으로 기대되고 있습니다.

TTT아키텍처 관련 논문 링크: https://arxiv.org/pdf/2407.04620v1

부루퉁의AI 네이버 블로그: https://blog.naver.com/ldlquddnr

부루퉁의 업데이트되는 챗GPT 전자책: https://vo.la/blbLY